個人用知的移動体のジェスチャインタフェースに関する研究

概要

近年、ジェスチャ認識デバイスの高精度化に伴いジェスチャ技術が急速に発達してきている。非接触型ユーザインタフェースとしてのジェスチャは、ボタンなどの使用より直感的であり、様々な分野への応用が期待されている。

一方、我々の研究室では個人の移動の知能化に着目し、個人用知的移動体AT (Attentive Townvehicle)と呼ばれる乗り物の研究開発を行っている。ATとは、搭乗者やATの周囲の環境に適応して移動する個人用の乗り物である。ATにはレーザレンジセンサと呼ばれている装置が搭載されており、周囲の障害物までの距離情報を取得することができる。また、駆動輪としてメカナムホイールを用いており、全方位平行移動やその場回転を行うことが可能である。そのため、ATの操縦方法は従来の乗り物とは異なってくる。これまでATの操縦はジョイスティックを用いてきたが、本研究ではより搭乗者の直感に合った操縦インタフェースとして、Xtionと呼ばれる深度センサ(ピクセル単位でデバイスからの距離を計測するセンサ)を利用した搭乗者の手のジェスチャを用いる仕組みを実現した。

ATは全方位平行移動とその場回転の2種類の動作が可能であるため、ジェスチャをそれらの2種類の動作に対応したものにする必要がある。そこで、搭乗者が全方位平行移動を行いたい場合は手の形状をグーにし、その場回転を行いたい場合は手の形状をパーにすることでATの動作の切り替えを行う。そのまま手を動かし、手の基準点の座標とXtionの認識範囲の中心座標の差分を計算することでATの動作(速度、進行方向、回転方向)を決定する。

また、搭乗者に自身のジェスチャがどのように認識されているのかという情報提示を行うために、ATのコンソールタブレット画面にジェスチャ認識画面を提示する手法を実現した。しかし、この手法では自身の手に注目し、情報提示画面を見ない搭乗者が複数名見受けられた。そこで、搭乗者に情報提示画面を見てもらうために、アニメーショングラフィクスを用いる手法も実現し、比較実験を行った。

比較実験より、アニメーショングラフィクスを用いる情報提示手法の方が、自分が行っているジェスチャが分かりやすく表現されており、ジェスチャ操縦を行うことが容易だったと感じた被験者が多いという結果が得られた。また、アニメーショングラフィクスによる情報提示手法では、ATの操縦のためのジェスチャを容易に習得できた被験者が複数名いたという結果も得られ、情報提示手法として効果的であることが確認された。

1 はじめに

我々が普段使用する機械は、ボタンやリモコンなどを用いて操作されることが多い。しかし、ボタンによる操作は機械を操作する位置が限定されるため、日常生活において不便な場合がある。また、リモコンを用いた操作方法の場合は、機械から離れた位置での操作が可能となる一方で、操作者がリモコンの位置を把握できていない場合もあり、機械を操作するためにリモコンを探し出すという手間が増える可能性もある。最近ではタッチパネルで操作する機械も日常的に広まってきているが、操作者の細かい指の動きが必要とされる。また、操作者が誤ってタッチパネルに触れてしまい、意図とは異なる動作が起こることも考えられる。一方、非接触型ユーザインタフェースとしてのジェスチャは、機械の操作インタフェースとしてボタンやリモコンなどを使用するよりも直感的であり、また、操作者の大まかな動きで機械を操作することが可能となるため、様々な分野への応用が期待されている。これまでにジェスチャを機械のユーザインタフェースとして使用する研究もされてきている。

これまで、カメラで撮影した画像を用いてジェスチャ認識を行う研究が数多く進められてきた。最近ではジェスチャ認識のためのデバイス技術の発達により、ジェスチャ認識技術が急速に発達してきている。ジェスチャによって操作可能な家電製品も発売されてきており、ジェスチャ認識技術は日常生活の中でより身近なものとなってきている。

ジェスチャ認識を行う際に、ジェスチャを行う人間の身体にジェスチャ認識用のデバイスを装着する研究も進められてきているが、これらの研究で提案されている手法ではジェスチャを行う人間が常にジェスチャ認識デバイスを身につけている必要があり、人間の自然な動作が制限されることや装着者のストレスにつながることなどが考えられる。そのため、ジェスチャを行う際に人間がジェスチャ認識デバイスを身につけていない、非接触型のユーザインタフェースとしてのジェスチャについて考える。

一方、我々の研究室では個人の移動の知能化に着目し、乗り物に情報処理機能や通信機能を持たせることで情報処理と移動や運搬などの物理行動を同時に支援する、という搭乗型コンピューティングのコンセプトに基づき、個人の移動を支援する仕組みとして個人用知的移動体AT (Attentive Townvehicle)と呼ばれる、自動走行が可能な個人用の乗り物の研究開発を行っている。

ATは搭乗者である人間やATを取り巻く環境に適応して移動する個人用の乗り物である。また、障害物が多く、走行できる幅が制限される屋内での利用を想定しているため、ATを利用して移動する際には細かい動きが必要とされる。そのため、障害物や歩いている人間を避ける際に任意の方向にすぐに移動することが望ましい。そこで、ATにはメカナムホイールという機構が搭載されている。このホイールにより、ATは全方位への平行移動とその場回転を行うことが可能となり、人間が急に近付いてきたとしても、真横に平行移動することで人間を回避することができる。さらに、ATにはレーザレンジセンサも搭載されており、ATの周囲の障害物までの距離情報を取得することができる。この情報を利用することで、ATはより安全に走行することが可能となる。

ATには搭乗者が目的地を指定することで、その位置まで自動走行を行う機能が搭載されている。この機能は屋内自動トランスポーテーション(Indoor Automatic Transportation)と呼ばれ、あらかじめ作成した屋内の地図情報を基に、搭乗者が目的地を指定するだけでATがその目的地までの経路を決定し、自動的に移動する。搭乗者はATの操作をする必要がないので、移動中の時間を他の作業に使うことができる。しかし、搭乗者自身がATを操縦したい場合もある。そのような場合はジョイスティックを使用することでATの操縦を行う。しかし、搭乗者自身がATを操縦する際、操作を誤って障害物に衝突する可能性がある。そこで、レーザレンジセンサより取得した距離情報を利用することで、ATが自動的に障害物を回避するように、移動速度と進行方向を調整する仕組みが実現されている。

このように、ATは従来の乗り物とは異なり、全方位への平行移動やその場回転を行うことができる。そのため、ATの操縦方法も従来の乗り物とは異なってくる。そこで、本研究では従来のジョイスティックによる操縦に加え、Xtionと呼ばれる深度センサを装備し、搭乗者の手のジェスチャを操縦に利用する仕組みを実現した。Xtionにより、ATは周囲の深度情報を取得することが可能となり、その深度情報を用いてジェスチャ認識を行う。搭乗者がATを前に進ませたい時は自身の手を前に突き出し、右に進ませたい時は手を右に動かす。この仕組みにより、搭乗者はより直感に合った動きでATの操縦をすることが可能になると考えられる。

また、搭乗者のジェスチャがATにどのように認識されているのかという情報を搭乗者に提示する仕組みとして、アニメーショングラフィクスを用いる手法も実現した。この情報はATに取り付けられているコンソールタブレットの画面上に表示され、搭乗者はその画面を見ることで自身のジェスチャがどのように認識されているのかという情報とATがどのような動作をしているのかという情報を知ることができる。

しかし、ATのコンソールタブレットの画面上に情報を表示することで、搭乗者がコンソールタブレット画面ばかりに注目し、搭乗者のATの周囲に対する注意力が低下してしまう恐れもある。そこで、情報提示画面にATのレーザレンジセンサから取得した周囲の障害物に対する情報も提示し、搭乗者に周囲の環境への注意を促す。搭乗者はこれらの情報からATの進行方向を調節するなどの対処が可能となる。

本章以降の本論文の構成について述べる。まず第2章で個人用知的移動体のコンセプトおよび構成と機能について述べる。次に第3章でジェスチャによって個人用知的移動体を操縦する際の操作方法および搭乗者に対する情報提示の手法について述べる。第4章では本研究で実現した、2種類の情報提示手法のどちらがより有効な情報提示を行うことができるのかを検証するために行った比較実験とその結果の考察について述べる。また、第5章では個人用知的移動体のジェスチャインタフェースをより有用なものとするための将来展望について述べる。第6章で関連研究を紹介し、第7章でまとめと今後の課題について述べる。

2 個人用知的移動体AT

AT (Attentive Townvehicle)は、搭乗者である人間やAT自身を取り巻く環境に適応して移動する個人用の乗り物である。本章では、ATのコンセプトおよびその構成と機能について述べる。

2.1 ATのコンセプト

搭乗型コンピューティングのコンセプトは、常に情報処理を支援するだけではなく、人間の移動や荷物などの運搬といった物理的な行動も同時に支援しようというものである。我々はこのコンセプトの下、新しい個人用の乗り物としてATを開発し、その研究を多岐に渡って行っている。

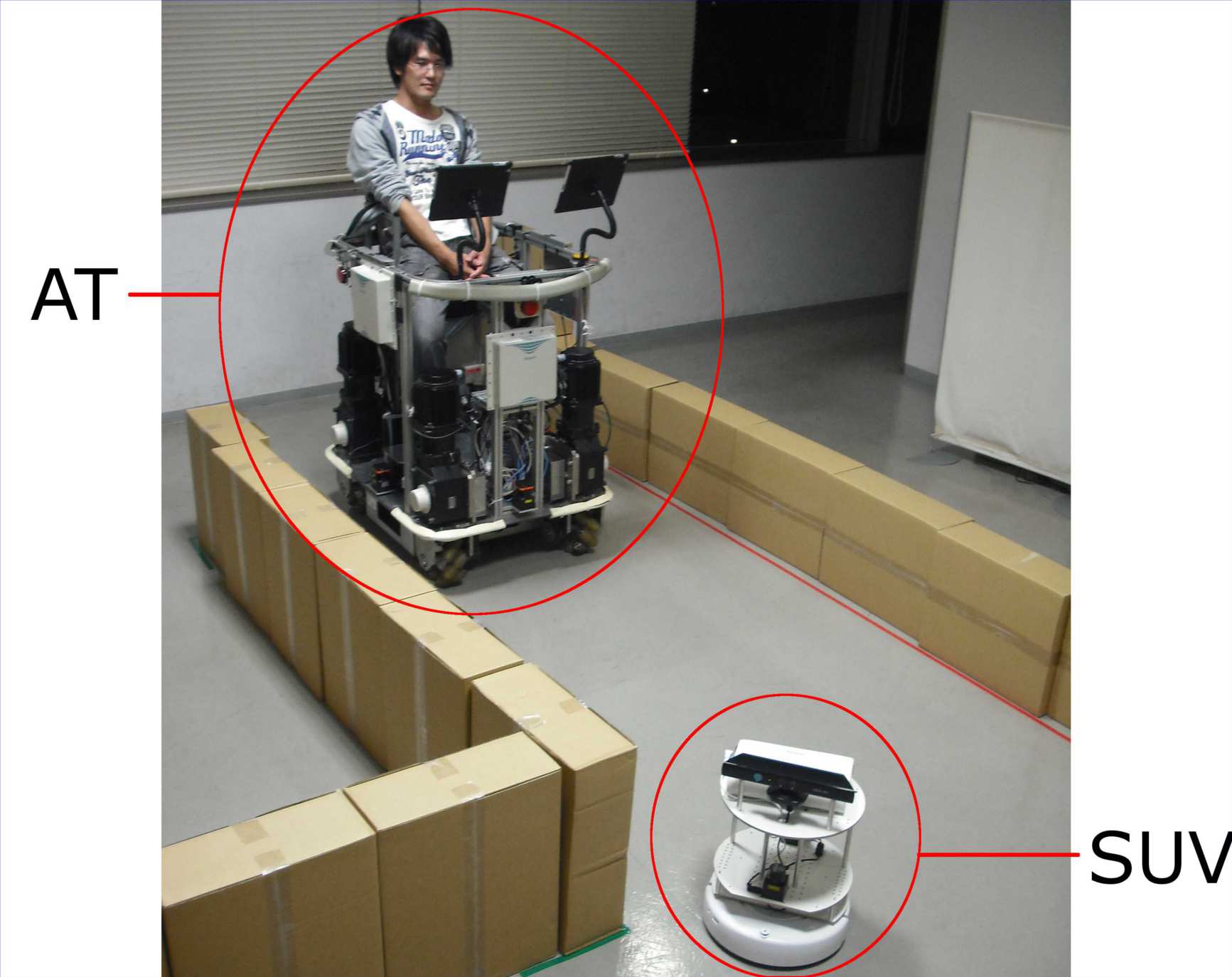

ATは周囲の状況を自らのセンサで認識することができる知的な移動体である。それだけではなく、図に示すようにATの周囲には小型の無人移動体(Small Unmanned Vehicle、以下SUV)が存在しており、それと通信を行うことでATはより多くの情報を得ることが可能となる。これらの機能により、人間はATに乗り込むことでより安全に移動することができる。

図2.1: ATとSUV

また、図に示すようにATを用いた研究領域は多岐に渡っている。我々はATをより知的な移動体にするべくATと「環境」「人間」「他のAT」という各要素間にある3つのインタラクションに「ATの個体としての自律性」を加えた4つの軸をもとに研究を進めている。図に示した4つの軸をこれまでに行われた研究を交えて説明する。

図2.2: ATに関わる研究領域

-

ATと環境とのインタラクション

ここで言う環境とは、物理的環境(実世界)と情報的環境(情報世界)の2つの意味を持つ。物理的環境とは、ATがセンサ類やモータにより認識あるいは作用することができる現実世界の対象や状態を指し、人間における知覚や運動に直接関わる対象に相当する。一方、情報的環境とは、ATがアクセスできるコンテンツや情報サービスの集合を指す。これに関して行われた研究に、実世界の対象物の認識や場所に連動した情報コンテンツの提示などがある。

-

ATと人間とのインタラクション

移動体がユーザの特性を把握し、移動体を利用すればするほどユーザに適応していく個人適応という研究課題がある。また、状況に応じた操作インタフェースを提供することも考えられる。具体的には、より直感的な操縦インタフェースを追求したり、非搭乗時の遠隔操作を可能にしたりするものである。これまでには、非搭乗時に自動的に人間を追尾させる研究も行われている。

-

移動体間通信を用いることで、AT同士は協調動作を行うことができる。これまでに、接近中のAT同士がお互いに通信して衝突回避を行う研究や先頭の有人のATを無人のATが追尾する連携協調動作の研究が行われてきた。また、アドホックネットワークの仕組みを用いて周囲のATとコミュニケーションを行うことが可能になるため、ATを用いたコミュニケーション支援システムやAT搭乗時の体験を共有・再利用するシステムが構築された。

AT間(移動体間)のインタラクション

-

人間の認知的能力を補うためには、移動体の感覚機能を強化し、自律的動作を実現することが求められる。これまでに、自動的に移動障害物を回避する研究が行われている。

ATの個体としての自律性

以上のように、ATは自身に搭載されたセンサ類やAT間・AT-サーバ間の通信によって3種類のインタラクションとAT自身の自律性を実現している。また、これらのインタラクションを通して獲得した情報を利用して、人間や環境への適応を可能にしている。

2.2 ATの構成

図2.3: 個人用知的移動体AT

ATの特徴として、全方位に平行移動が可能である点とその場で回転できる点が挙げられる。この機能により障害物や人間などを避ける際により効率的に動くことができる。一般的な乗り物は、停止している状態から真横に動くことができないため、障害物や人間などが乗り物の近くまで接近してしまうと回避しきれずに衝突してしまう。しかし、全方位に平行移動が可能ならば、このような場面でも障害物や人間などを回避することが可能となる。

本研究では全方位平行移動を可能とするために、メカナムホイールという機構が採用されている。以降でその仕組みについて詳しく述べる。

2.2.1 メカナムホイール

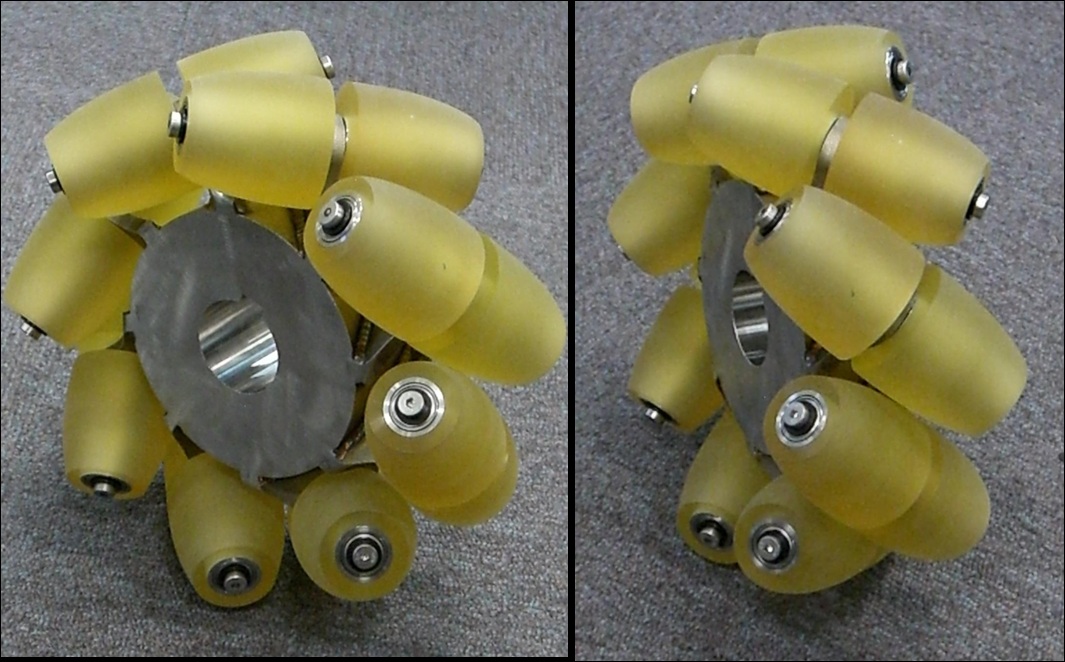

本研究で使用されているメカナムホイールの外観を図に示す。メカナムホイールは車軸に対して45度傾けられた小型のローラーが車輪の周囲に等間隔に取り付けられた構造となっている車輪である。

図2.4: メカナムホイール

メカナムホイールは、車軸のついている中心の車輪はモータによる制御が可能であるが、周囲のローラーには動力が存在せずにフリーに回転するだけとなっている。メカナムホイールは正回転する際、ホイール自体は前方向に移動するように回転するが、車軸に対して45度傾けられて取り付けられているローラーによりローラー軸方向に対する推進力が抑制される。この結果、メカナムホイールはローラー軸と垂直の方向に推進力が発生する。したがって、4輪の推進方向の組み合わせによって全方位平行移動が可能となる。

しかし、メカナムホイールでは駆動系のないローラーを回転させて移動を行うため、メカナムホイールに働く力を正確に解析することが困難となる。そのため、モータに与えたホイールに対する出力値から実際の移動距離と方向を正しく把握することは難しい。また、モータの出力が全て推進力に変換されるわけではないので、バッテリーの消費量に比べて走行距離が短くなるという問題も生じる。さらに、メカナムホイールは弾力性に乏しく、走行による振動や衝撃が搭乗者に直接伝わってしまう。これにより、快適性が損なわれる問題も生じてしまう。このような点は今後改良していく必要性があるだろう。

2.2.2 全方位平行移動のメカニズム

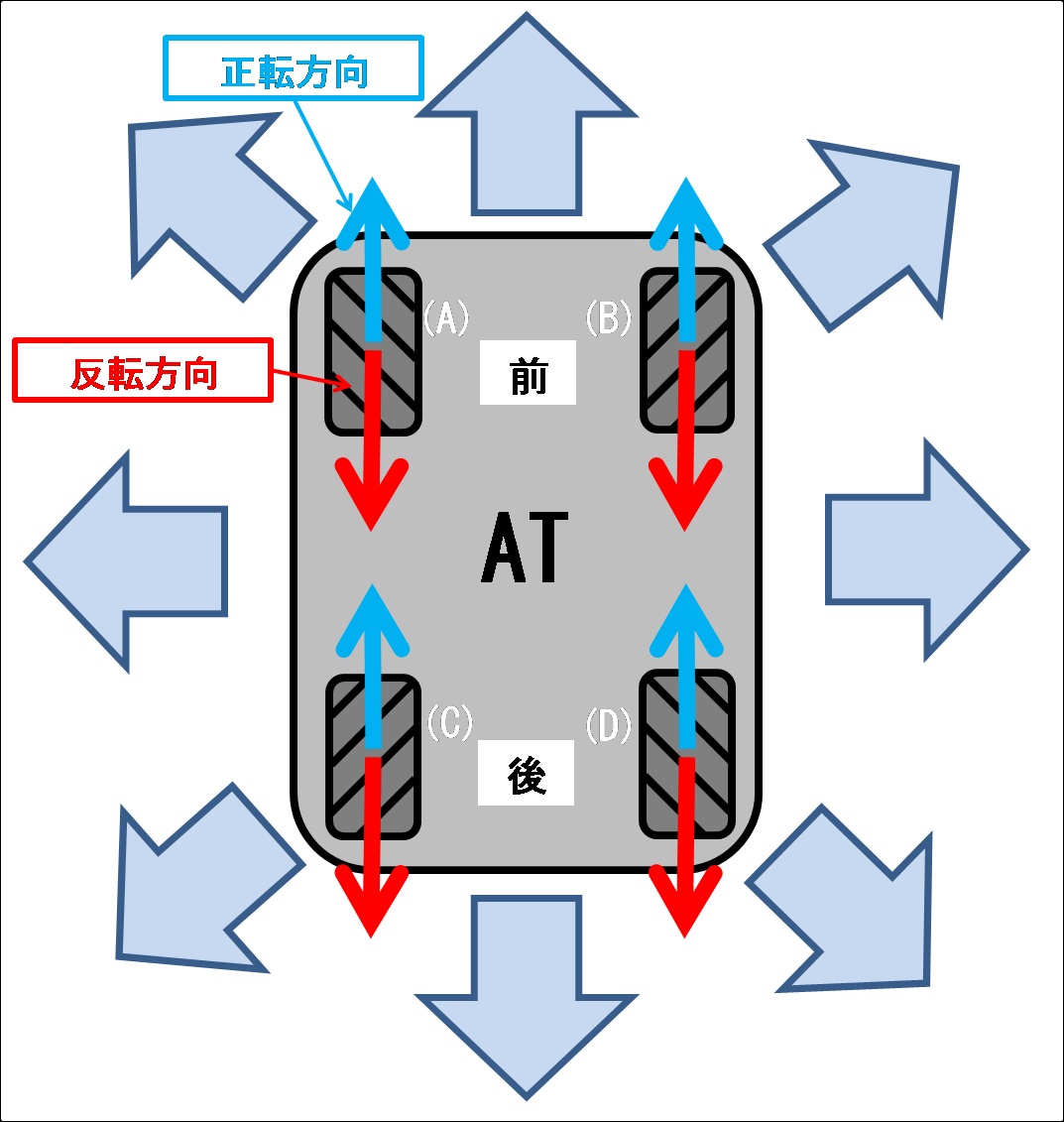

全方位平行移動およびその場回転は、図のように配置された4個のメカナムホイールを個別に制御することで実現している。メカナムホイールとベルトでつながれた高トルクのサーボモータは任意の速度制御が可能であり、またトルクを0にすることで空転させることもできる。

図2.5: 全方位平行移動のメカニズム

ATを前後左右に動かす時は、4輪の回転速度を等速にして、それぞれの回転方向(正転または反転)を動く方向に合わせて調整する。例えば右方向へ動かす時は、図の(A)と(D)を正転方向、(B)と(C)を反転方向に動かすことで移動させることができる。

車体から45度の方向へ動かす時は、右斜め前へ移動することを例にとると、(A)と(D)を正転方向に動かし、(B)と(C)を空転させることによって移動させることができる。それ以外の任意の方向へ移動する時は、4輪の回転数を適度に調整することにより実現できる。なお、その場回転する際は(A)と(C)を正転方向(あるいは反転方向)、(B)と(D)を反転方向(あるいは正転方向)へ回転させることにより実現される。

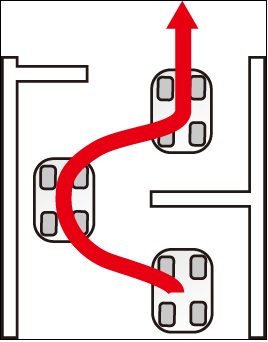

上記の方法により、駆動輪として4つのメカナムホイールを用いたATは本体の向きを変えることなく任意の方向へ移動することが可能となり、図のように障害物をスムーズに避けることができる。これまでに実用化されている通常の移動体には不可能な、静止状態から真横に移動することが可能となり、ATは障害物や人間が接近している場合でも衝突することなく安全に回避を行うことができる。

図2.6: 全方位平行移動による障害物回避

2.3 システム構成

前節ではATの駆動系について詳しく説明したが、ここではAT全体の構成について説明する。

2.3.1 ハードウェアおよびソフトウェア

ATの車体はアルミ材で構成されており、屋外と屋内の両方で利用できるように車体の幅を屋内の扉やエレベータの入り口を通り抜けることが可能な大きさに抑えられている。なお、ATの操縦インタフェースについては2.4節で説明する。

さらに、ATは周囲の環境の情報を取得しながら自動走行を行う。そのため、自身の位置や周囲の障害物などの情報をすべて環境から取得しなければならない。環境から情報を取得するためにATは以下のデバイスを用いており、移動に伴う環境の変化に応じて情報を取得することができる。

-

レーザレンジセンサ

壁沿い走行や障害物回避など幅広い状況で全方位にある障害物との距離を測定するのに利用される。レーザレンジセンサは床面から一定の高さの平面上に扇状の距離情報を最大30m、角度240度の範囲で得ることができる。このレーザレンジセンサをATの前後左右に各1台ずつ設置し、後述するレンジセンササーバPCで4台からの距離情報を統合させることにより360度全方位の距離情報を取得することができる。

-

RFIDタグリーダ

地図との照合により自身の現在位置の確認および修正と目的地の認識に利用する。RFIDタグリーダは無電源非接触のICタグであるRFID(Radio Frequency Identification)タグを読み取ることができる。RFIDタグリーダもATの前後左右に各1台ずつ設置した。4台のタグリーダはそれぞれ固有のIDを持っており、どのリーダがどのIDを持つタグを読み取ったかを判別することが可能であるため、車体の向きも同時に判別することができる。

-

3軸角度センサ

車体の傾斜角や回転角を求めるために利用する。

これらのセンサを用いることで、移動に伴う環境の変化に応じて暗黙的に情報を取得することができる。

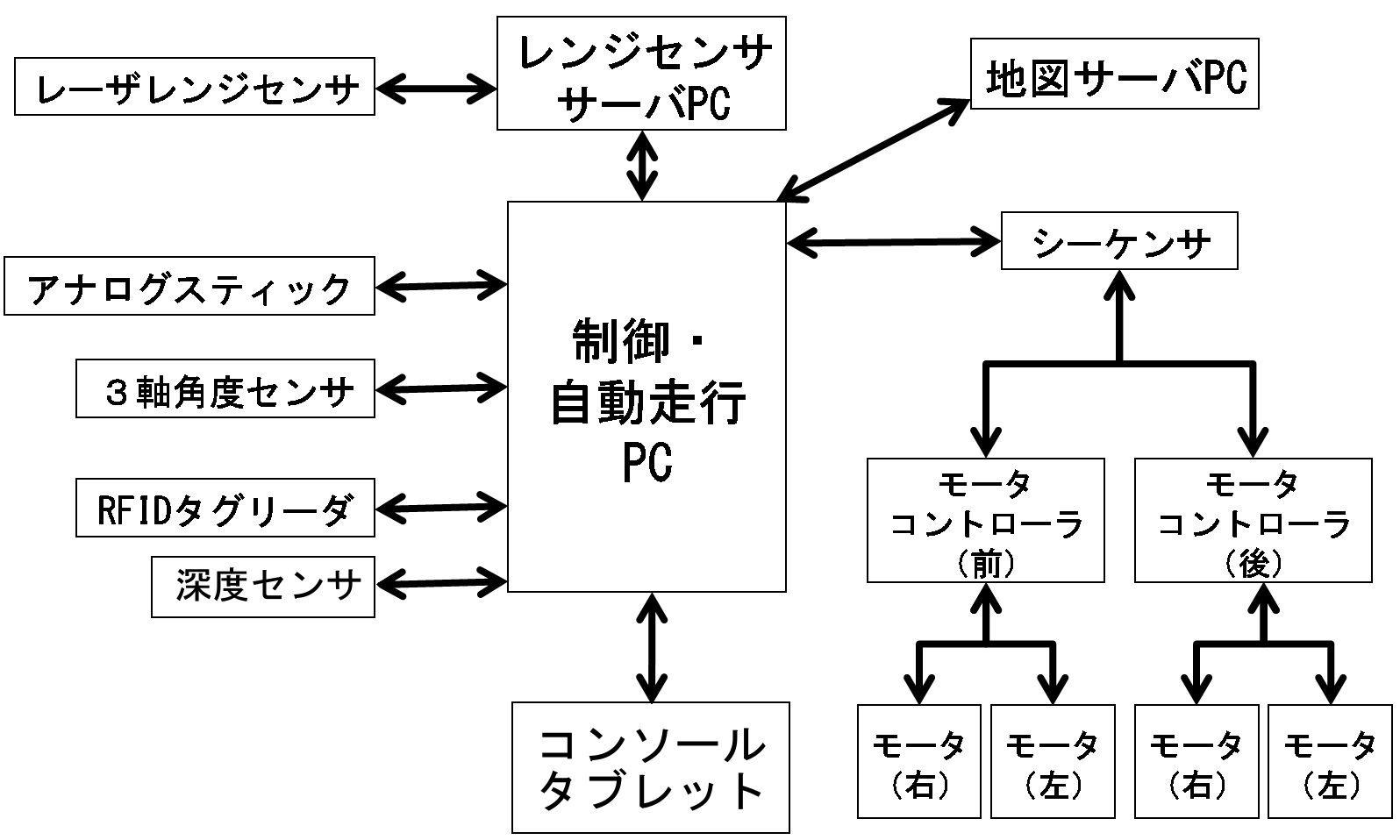

図2.7: システム構成

図からも分かるように、ATには複数のPCとタブレットが使用されており、モータの制御、センサ・デバイスの制御、地図に基づく経路・動作の生成などを行っている。ATに搭載されているPCは、制御・自動走行PC、レンジセンササーバPCでこれらのPCは互いに有線で接続されている。また、モータ制御PCとシーケンサも有線によって接続されている。地図サーバはATとは別で、環境側に設置されていることを想定しているため、地図サーバPCと制御・自動走行PCは無線によって接続されている。それぞれのPCの主な役割は以下の通りである。

-

制御・自動走行PC

モータに繋がるシーケンサなどの制御系デバイスが接続されているPCであり、モータコントロールサーバと呼ばれるモジュールが稼働している。ATには、4個のメカナムホイールそれぞれと繋がっているモータを個別に制御するためのデバイスが装備されている。このPCで、進行方向や速度の入力を元に、各モータの速度パラメータを求め、その値をシーケンサに送る。シーケンサはモータコントローラを通して各モータのトルク調整を行う。このモータコントローラはATに2つ装備されており、一方は前方の左右2つの、もう一方は後方の左右2つのメカナムホイール用モータの出力トルクを制御している。また、各PCからのモータ制御の命令はこのPCを介して行われる。他にも、RFIDタグのIDを保持するRFIDサーバもこのPCには組み込まれており、走行中に読んだタグを前後左右それぞれ10個まで保持することができる。なお、読み取ったタグ情報は一定時間が経過すると破棄される。これは、最後にタグを読み取ってから時間が経ってしまうと、そのタグは位置情報として役に立たないものになるためである。

また、自動走行のタスクを実行するプログラムもこのPCで稼働しており、自動走行のタスクを実行する命令が発行されると、モータコントロールサーバがモータに命令を送り自動走行を行う。

-

レンジセンササーバPC

レンジセンササーバと呼ばれるモジュールが稼働しているPCである。レンジセンササーバは4台のレーザレンジセンサを使用してATの周囲の物体までの距離を常に測定しており、受信した距離情報をAT中心の極座標に変換している。ATはこの値を利用して自動走行や衝突回避を行っている。

また、ATには搭乗者用のユーザインタフェースデバイスとしてコンソールタブレットが装備されている。

-

コンソールタブレット

搭乗者の正面に2台並べて設置されたデバイスであり、タッチパネルディスプレイが備えられている。ディスプレイには操作用のコンソールが表示され、自動走行の際に搭乗者はこのコンソール画面から目的地を設定することができる。

さらに、ATの外部に以下のサーバPCが稼働し、AT内のPCと無線で通信し、ATを補助している。

-

地図サーバPC

屋内の地図、RFIDタグのIDとその位置およびRFIDタグ間の距離の情報を格納したデータベースを保持しているPCである。ATからの現在位置・目的地情報と情報取得要求に応じて、現在位置付近の地図や現在位置から目的地までの経路と動作の生成を行い、生成された経路と動作をATに送信する。さらに、地図サーバは通信可能な範囲に存在するATの位置を常に把握している。

また、ATは移動体であるため、このように多くのPCやセンサ・デバイスを装備しても搭乗者に負担をかけることはない。むしろ、できるだけ多くのセンサから獲得した情報に基づいて実世界の状況を認識し、物理的な行動に反映することで、人間の行動をより適切に支援することを目指している。

2.4 操縦インタフェース

ATの操作は、図に示すアナログスティックを倒したりボタンを押したりすることによって行うことができる。

図2.8: ATの操作に用いられるコントローラ

このコントローラは制御・自動走行PCとUSBケーブルで接続されている。コントローラには、アナログスティック、Cボタン、およびZボタンが備わっており、それぞれ以下のような機能を持つ。

-

アナログスティック

倒す角度と傾きの度合いによってATが移動する方向と速さを決めることができる。また、アナログスティックから指を離すとATは停止する。

-

Cボタン

Cボタンを押しながらアナログスティックを左右に倒すと、倒した方向に応じてその場回転を行うことができる。

-

Zボタン

押しながらアナログスティックを倒すことで駐機モードへ切り換えることができる。この駐機モードとは搭乗者がATを降りた後にATが自動的に人の邪魔にならないような隅や袋小路に移動するモードのことである。このモードにより、搭乗者が屋内の任意の場所でATから降りたとしてもそのATが屋内を歩く人の邪魔になることはない。

本研究ではこのコントローラによる操縦に加え、Xtionと呼ばれる深度センサデバイスを用いたジェスチャによる操縦も実現した。図にXtionの全体図を示す。

このXtionは認識範囲の深度情報を取得することができる。ATはこの深度情報を元にジェスチャ認識を行う。このジェスチャ操作の詳細については第3章で述べる。ジェスチャで操縦を行うことにより、搭乗者はより直感に合った操縦をすることが可能となる。

図2.9: ジェスチャ操作のために使用するXtion

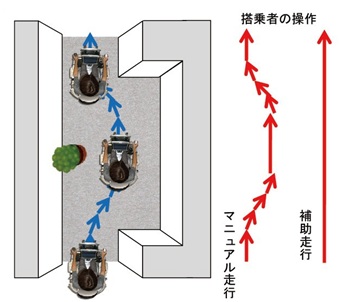

2.5 補助走行

ATは屋内の走行を目的としたものであるため、その走行中には走行できる幅の狭い空間や室内の障害物が多く存在していると考えられる。そのような空間を走行する際に、搭乗者は衝突を避けるために細かな操作を要求される。しかし、常に周囲の障害物を警戒しつつ操作することを安全であるとは言い難い。そこで、そのような空間での搭乗者の操作を支援する仕組みとして、補助走行機能が実現されている。

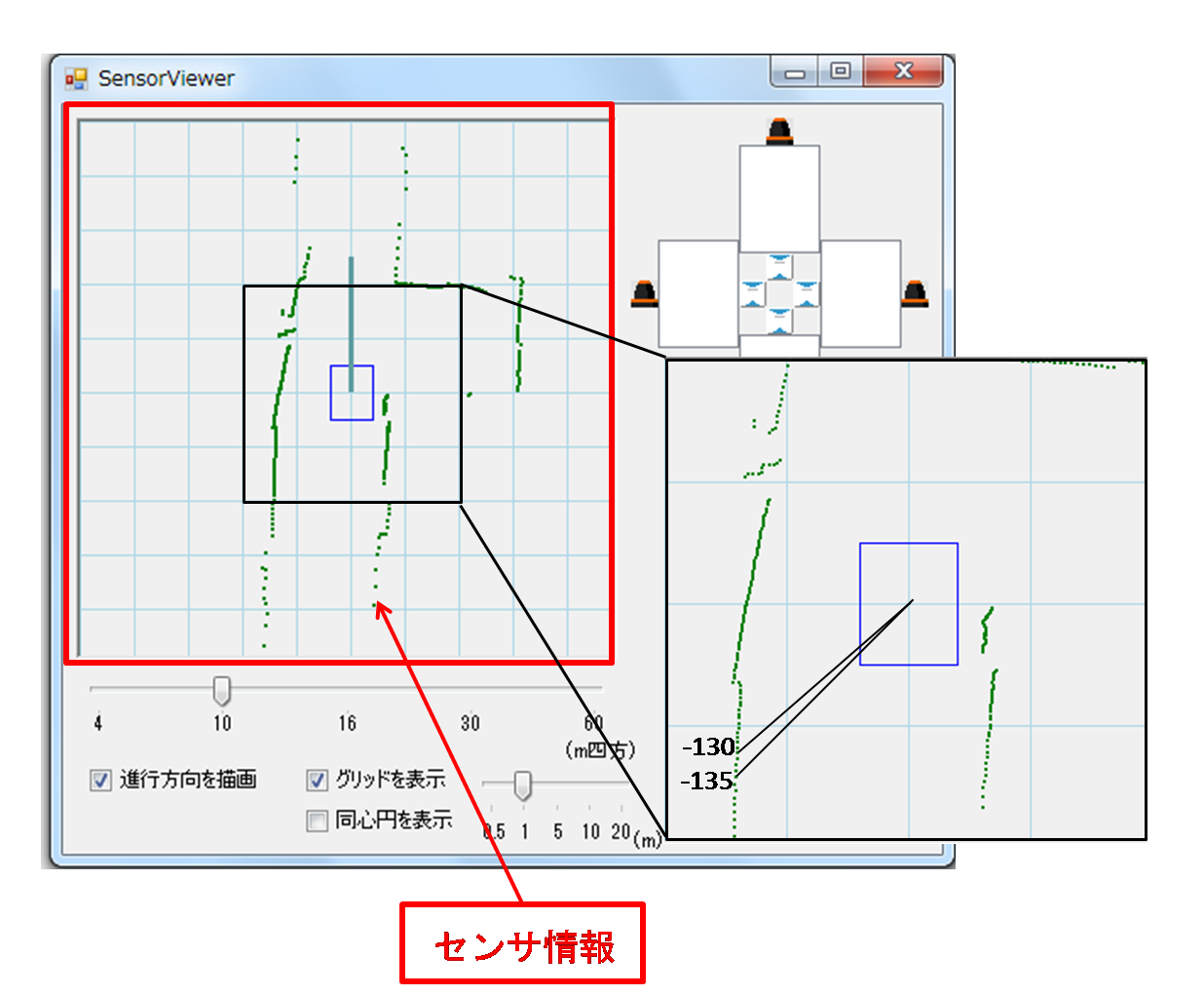

この補助走行機能では、搭乗者は自分自身が進みたい大まかな方向と速度をATに伝えるだけで良い。ATはその方向と速度を元とし、さらにATに搭載されているレーザレンジセンサの情報も加味し、安全に走行できる方向と速度を計算し、その情報をATの走行に反映させる。図にレーザレンジセンサの値から障害物までの距離を可視化した図を示す。図中の緑の点がATの周囲をレーザレンジセンサが1度ごとに取得した全方位の距離情報を表している。また、図中の青い矩形はATを表している。

この情報を用いることで、搭乗者は簡単な操作で安全に移動することが可能となる。

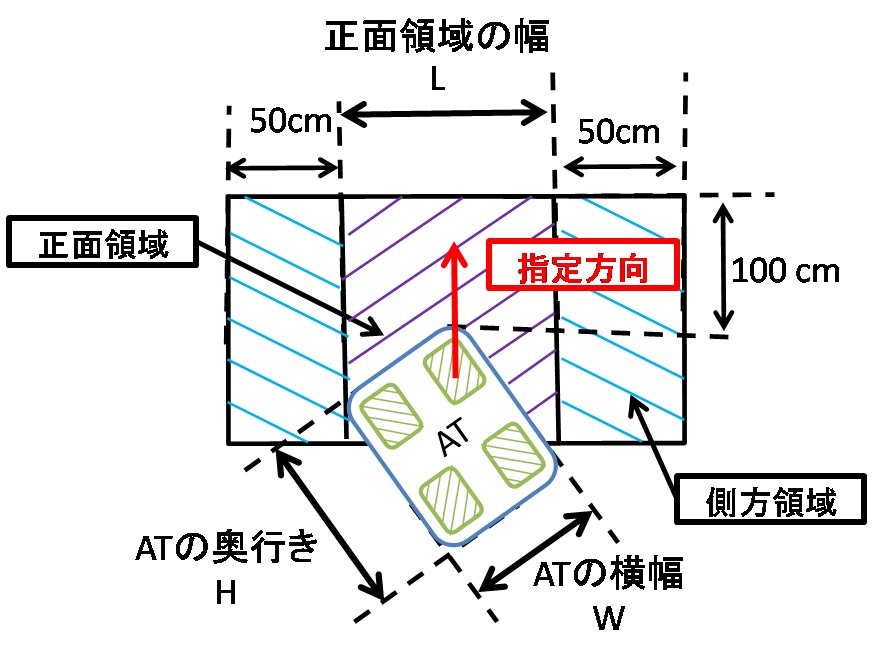

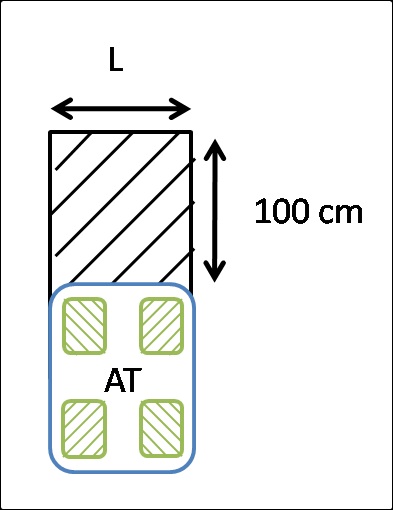

ATはレーザレンジセンサが1度ごとに取得した周囲の障害物点までの距離に基づいて速度と移動方向の調整を行う。ただし、この際に全方位の障害物を考慮する必要はない。そこで、搭乗者が指定する方向に対して障害物を考慮する範囲が図のように設定されている。

図2.10: レーザレンジセンサが取得した全方位の距離情報

図2.11: 障害物の考慮範囲

障害物を考慮する範囲は図に示す通り、正面領域と側面領域に分類されている。これはATが走行するために必要な幅が搭乗者の指定する方向により異なるからである。ここで、正面領域の幅Lは式(1)により求められる。

(式1)

図にあるように、HはATの奥行き、WはATの横幅である。xとyは搭乗者が指定する進みたい方向を表す。搭乗者が正面を向く方向をy座標とし、それと直行する方向をx座標とする。

補助走行モードでは搭乗者の指定する方向から±90度以内の範囲にある障害物点が移動方向と速度の調整の対象となる。考慮される範囲が限定されているのは、搭乗者が指定する方向と逆の方向に障害物があったとしても、搭乗者が指定する方向へ進む際には衝突の可能性がないためである。

図の正面領域については、障害物を考慮し移動方向と速度の調整を行い始めるATと障害物の距離が100cmに設定されている。これは、考慮する対象の障害物が近すぎる場合に、障害物を回避しきれず衝突してしまう可能性や搭乗者の指定した方向と調整を行う方向の差が大きくなりすぎる可能性があるためである。

また、搭乗者の指定する方向のみを考慮するだけでは、幅の狭い空間を走行する場合に減速することができない。そのために側方領域も考慮し減速を行う。側方領域では減速を行うためのATと障害物の距離が50cmに設定されている。

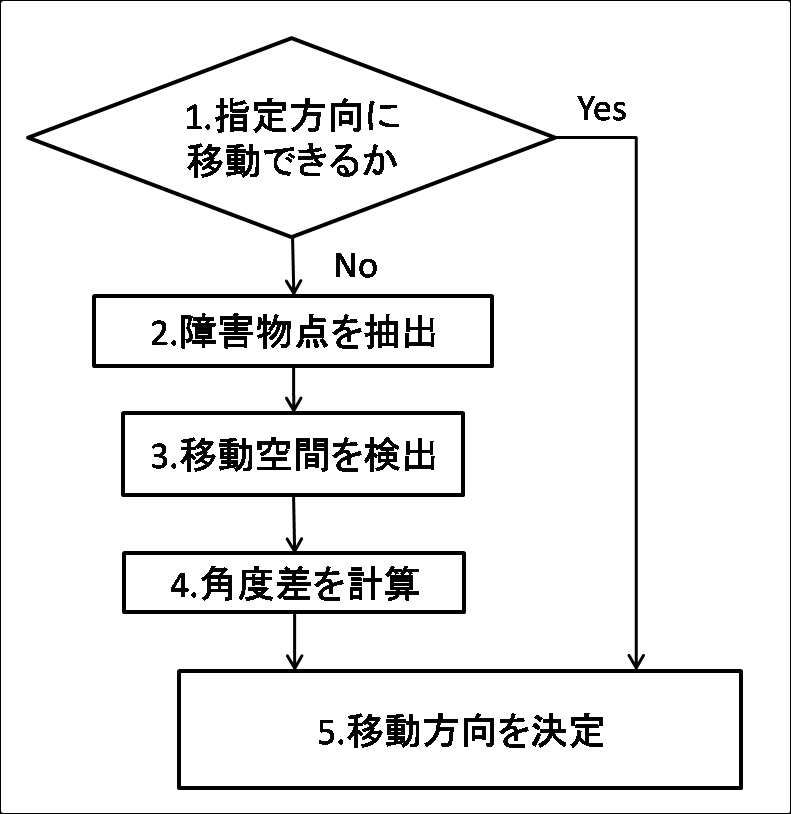

2.5.1 移動方向調整

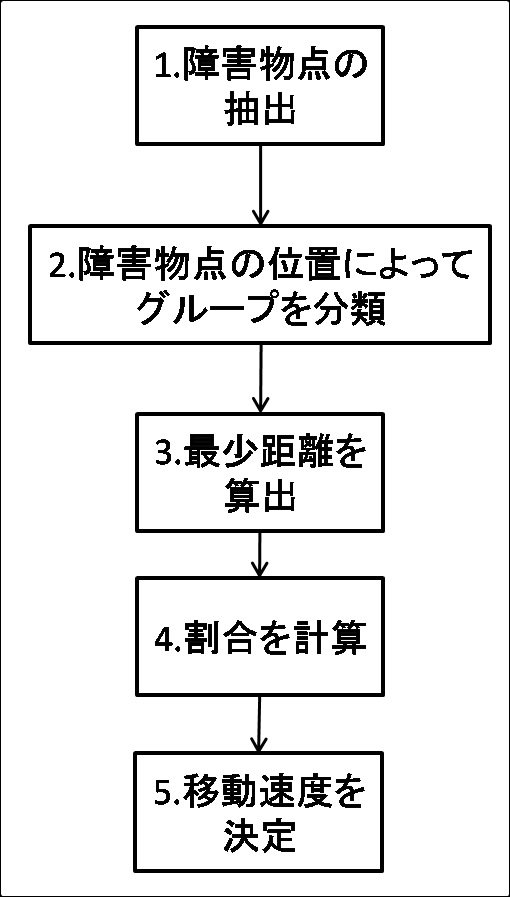

進行方向に障害物がある場合、その障害物を自動的に避けて進む機能がATには実装されている。この機能により、搭乗者は大まかな移動方向を指し示すのみで安全な移動が可能となる。この移動方向は搭乗者が指定する方向に基づいて図の手順で決定される。

図2.12: 移動方向を決定する手順

-

搭乗者が指定した方向にATが走行可能かどうかを計算する。式(1)によって求まるATが走行するために必要な幅を計算し、図で示すように、ATの進行可能な幅の前方100cm以内を正面領域とは別に走行可能領域とする。ATのレーザレンジセンサで取得した値を精査し、走行可能領域に障害物が存在する場合は、以降のステップに従って、移動方向を計算する。

-

搭乗者が指定した方向から±90度以内で、指定した方向の100cm以内にある障害物点をATのレーザレンジセンサの値から取得する。

-

ATが移動可能な空間を検索する。2で求めた障害物点間の距離を計算し、その距離がATの走行に必要な幅より小さければ走行不可能と見なす。これを繰り返し、走行可能な空間を見つける。

-

3により求まった空間の中心と搭乗者が指定した方向の角度差を計算する。移動可能な空間が複数検出された場合はその全ての空間について計算を行う。

-

4で計算された角度差が最も小さい方向を移動方向として採用する。

図2.13: ATの走行可能領域

以上の手順でATの移動方向を計算することにより、障害物に衝突することなく移動可能な方向が計算される。図のような場合、補助走行機能なしでは、搭乗者は周囲の障害物に注意しながらATを操作しなければならず、衝突の危険性が高くなる。しかし、補助走行により移動方向の調整が行われることで搭乗者の負担も減り、より安全に走行することが可能となる。

図2.14: 補助走行説明図

移動方向の調整が行われた場合、計算された移動方向と搭乗者の指定した方向の角度差が小さければ搭乗者の指定した方向に近い方向で移動することが可能であるが、計算された角度が搭乗者の指定した方向と大きく異なっていた場合、そのままATが移動すると搭乗者の意図した方向に進めないという問題が生じる。そのため、計算される移動方向は搭乗者の指定した方向の±90度以内になるように設定されている。もしも計算された移動方向と搭乗者の指定した方向が90度以上異なっている場合は移動方向の調整が行われず、搭乗者の指定した方向に進み続ける。すなわち、障害物に向かって進み続けることになるので後述する移動速度の調整によりATは減速しながら進むことになる。

また、このように移動方向の調整が行われた際に、本来走行していたコースから大きく逸れてしまう場合や、壁際を走行していたATが通路の中心を走行することになり歩行者の邪魔になる場合などが起こり得る。そのため、ATには移動方向が変更された際に、障害物を避けた後で障害物を回避する前に走行していたコースに戻るという機能も実装されている。

搭乗者が指定した方向と補助走行機能によって計算された移動方向が異なる場合には、指定方向と移動方向の差分とその際の移動速度をベクトルとして記録する。その後、搭乗者の指定方向と計算された移動方向が等しくなった際に障害物の回避が終了したと見なして、障害物を回避する前に走行していたコースに戻ることができるかどうかを計算する。この際に、先に記録していたベクトルを用いる。記録していたベクトルと、搭乗者の指定した方向に対して軸対称となるベクトルを求め、その方向に移動可能かどうかを計算する。もし移動可能であった場合には、出力された速度の分だけ記録していたベクトルを減算する。この動作を記録したベクトルの和が0以下となるまで繰り返し行う。これにより、従来の走行コースより障害物を回避するために動いた分だけ戻ることとなり、従来の走行コースに戻ることが可能となる。

なお、障害物を回避している過程で搭乗者の指定する方向が変更された場合は、搭乗者の目的のコースが変更されたと見なし、それまでに蓄積されていた指定方向と移動方向の差分とその際の移動速度のベクトルの記録は破棄される。

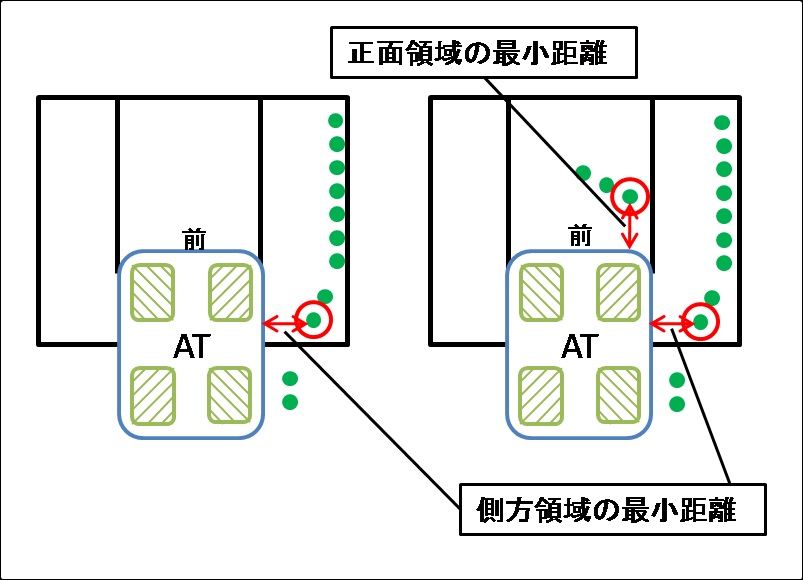

2.5.2 移動速度調整

速度調整を行う場合は、搭乗者が指定した速度を元にレーザレンジセンサから得た距離情報を利用して減速する割合を決定する。この速度の調整は図で示す手順で行われる。

図2.15: 移動速度を決定する手順

-

搭乗者によって指定された方向から±90度の範囲にある障害物点のうち、ATとの距離が100cm以下のものを選択する。

-

1で選び出された障害物点が正面領域と側方領域のどちらに含まれるのかを計算する。この際に、正面領域の幅が搭乗者の指定する方向によって異なることに注意する。

-

正面領域と側面領域のそれぞれでATとの最小距離を計算する。

図では、丸で囲まれた点がそれぞれの領域におけるATとの距離が最小となる障害物点である。なお、図の左の場合、正面領域にATとの距離が100cm以下となる障害物点が存在しないため、側方領域の障害物点のみを考慮する。

-

正面領域と側方領域それぞれについて、減速を行い始める距離と3で求めた最小距離を元に減速する割合を決定する。図の左の場合の最小距離を30cmとすると、側方領域の減速開始距離は50cmであるために減速する割合は30 / 50 = 0.6となる。同様に右の場合もそれぞれの最小距離を30cmとすると、正面領域においてはその減速開始距離が100cmであるために、減速する割合が30 / 100 = 0.3となり、側方領域においては左の場合と同じく0.6となる。

-

4で計算した正面領域と側方領域のそれぞれの割合のうち、小さい値と搭乗者の指定した速度を乗算し、移動する速度を求める。図の左の場合では、側方領域にのみ障害物点があるため、正面領域は考慮されず、減速する割合は側方領域の値である0.6が採用される。また、右の場合では、正面領域の値が0.3、側方領域の値が0.6と計算されるため、より小さい方の0.3が減速する割合として採用される。

図2.16: 減速割合の決定例

このように減速する割合を計算することで、ATと障害物との距離が近い場合により減速される。このために、ATはより安全に走行することが可能となる。

しかし、このように計算すると、搭乗者の指定した速度が遅かった場合に、障害物との距離を計算して減速すると、移動が可能であるにもかかわらず計算された速度が遅すぎるために、ほとんど移動することができない場合が起こり得る。そのために、移動速度の下限値が設定されている。計算された速度がその下限値を下回る場合はその下限値が採用される。これらの機能により、ATは障害物との距離に応じて自動的に減速を行うことが可能となる。

また、移動方向の調整により調整角度が±90度を超えた場合で、障害物に向かって進み続ける時、障害物との距離が20cmを下回ると移動速度が0となり、ATは停止する。このため、補助走行モードでは搭乗者が細かな操作をしなくても障害物に衝突することなく、安全な走行を行うことが可能となる。

次章で説明するジェスチャインタフェースは、この補助走行機能を前提としている。

3 個人用知的移動体のジェスチャインタフェース

前章で説明したように、ATは従来の乗り物とは異なり、全方位への平行移動やその場回転を行うことができる。そのため、ATの操縦の仕方も従来の乗り物とは異なってくる。そこで、本研究ではより搭乗者の直感に合った操縦インタフェースとして手のジェスチャを利用する仕組みを実現した。

ジェスチャは人間にとってより直感的なものである。また、近年のジェスチャ認識デバイスの発達に伴い、ジェスチャ認識技術は急速に発展してきており、非接触型のユーザインタフェースとして様々な分野への応用が期待されている。

さらに、ATの操縦インタフェースとしてのジェスチャを考えた場合、常に操作のためのデバイスに触れている必要性がなく、また、より単純な動作での操縦が可能となるので、搭乗者の負担を減らすことができる。

本章では、本研究で開発した個人用知的移動体のジェスチャインタフェースについて述べる。

3.1 ATにおけるジェスチャ認識

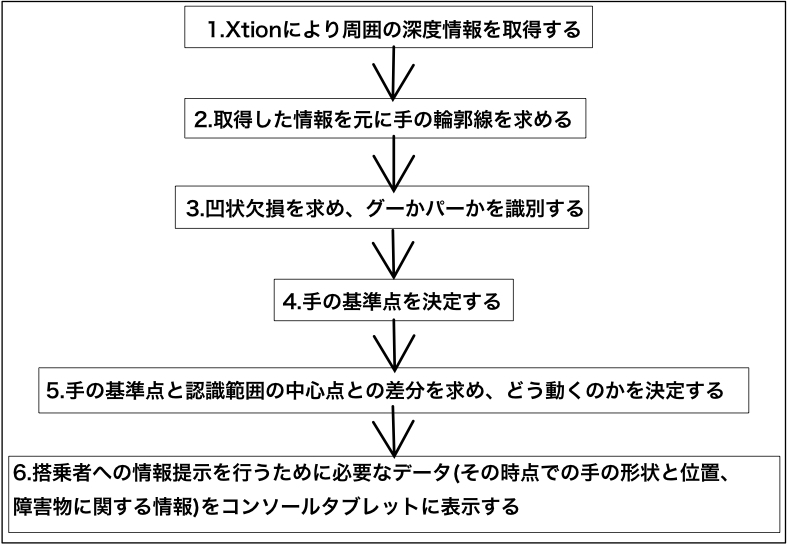

図3.1: ジェスチャ認識の流れ

2.4節でも述べたように、本研究ではジェスチャ認識のためにXtionと呼ばれるセンサデバイスを用いている。このデバイスによりATは周囲の深度情報を取得することができる。ATはこの情報を元に搭乗者の手を認識し、ジェスチャ認識を行う。図にジェスチャ認識の流れを示す。

-

図にXtionから取得した周囲の深度情報を可視化した図を示す。

ATに取り付けられているXtionは上を向いているため、この深度情報には手以外の天井などのデータも多く含まれている。図にXtionの取り付け位置を示す。

図には余分なデータが多く含まれているので、このままジェスチャ認識の処理を行うのは困難である。そこで、Xtionが深度情報を取る範囲をXtionから一定距離内に制限する。それにより得られる深度情報を可視化した図を図に示す。これにより、Xtionから離れたところにある天井などの余分な情報を減らすことができ、画像処理を行うことが容易になる。

-

2で得られた手の輪郭線から、その凸包を求め、特徴量として凹状欠損を見つける。凸包とは与えられた輪郭点の外側の点を結んでできる線分の集合である。図に図より求められる凸包の図を示す。

次に凹状欠損を見つけ出す。この凹状欠損とは、手の輪郭線と凸包の線分で囲まれるそれぞれの部分で、凸包の線分との距離が最も遠い手の輪郭線上の点の集合である。この距離が一定の長さ以上である点を凹状欠損として用いている。この様子を図に示す。

ATはこの凹状欠損の情報を元に認識されている手の形状がグーであるかパーであるかを識別する。グーとパーでそれぞれ凹状欠損の数を求めた様子を図に示す。

グーでは凸包の線分と輪郭線の距離が短いため、凹状欠損は見つけられない。しかし、パーの場合は凸包の線分と手の輪郭線間に十分な距離があるため、複数の凹状欠損が見つけられている。なお、凹状欠損として認識された点を赤色の点で示している。

ATの動作には全方位平行移動とその場回転の2種類がある。それらのモードを明示的に切り替える手段として、手の形状をグーとパーに切り替えることを用いる。

-

ジェスチャ操作は、認識されている手の基準点の座標とXtionの認識範囲の中心点の座標を比較し、その差分を計算することで行われる。手の基準点の決め方はグーの場合とパーの場合でそれぞれ異なる。図にそれぞれの場合の基準点を描画した図を示す。赤丸で示している点がそれぞれの手の基準点であり、図中の中心の点がXtionの認識範囲の中心点を表している。グーの場合は図の左下を原点とし、まず、手と認識されている領域内の点でy座標が最も大きく、x座標が最も小さい点を決定し、その点からx軸方向に5ピクセル、y軸方向に‐15ピクセル移動した点を基準点としている。一方、パーの場合は3で求められた凹状欠損の座標の平均を手の基準点としている。

-

4で求めた手の基準点とXtionの認識範囲の中心点の座標の差分を計算し、ATの進行方向、速さ、回転方向を決定する。Xtionの認識範囲の中心点を原点とする直交座標値を取得し、この座標を極座標に変換することでATの進行方向と速さを求める。ATの進行方向の指定はATの前方を0度、左側をマイナス、右側をプラスとした-180度~+180度の範囲で行う。また、座標距離から移動速度を計算する。回転方向の指定については3.2.2項で述べる。

-

ATのジェスチャ操縦をする際に、搭乗者のジェスチャがどのように認識されているのかについて、情報提示を行う。なお、搭乗者に対しての情報提示については3.3節以降で詳細に述べる。

搭乗者に対しての情報提示はATのコンソールタブレットの画面上で行われるため、ATからコンソールタブレットへジェスチャ認識結果に関するデータが送信される。送信されたデータを基に、その時点での搭乗者の手の形状がグーとパーのどちらに認識されているのか、また、手の位置はどこにあるのかなどの情報提示を行う。さらに、3.4節の情報提示手法では周囲の障害物に対する情報の提示も行う。

以上のような処理を繰り返し行うことでジェスチャ操縦を可能としている。

次に、グーとパーによるATの操作方法について詳しく述べる。

3.2 ジェスチャによるATの操縦

ATには全方位平行移動とその場回転の2種類の動作がある。そのため、ジェスチャはそれら2種類の動作に対応したものにする必要がある。そこで、図に示すように、搭乗者が平行移動を行いたい場合は手の形状をグーにし、その場回転を行いたい場合は手の形状をパーにする。それぞれの形状のまま手を動かすことでATを操作する。

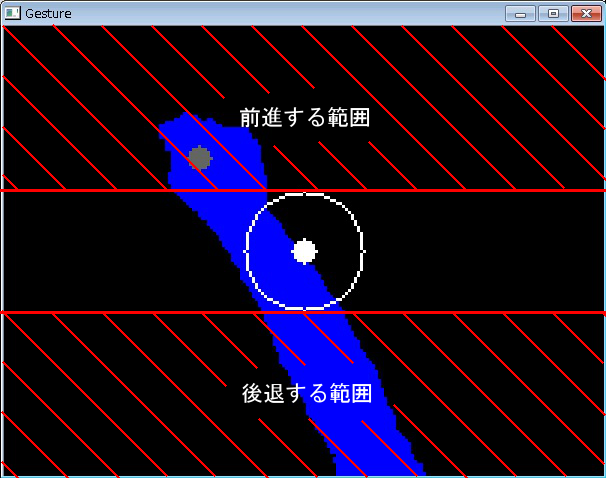

ATがジェスチャ認識を開始するために、搭乗者は自らの手をXtionの認識範囲の中心付近にかざす必要がある。これによりATにジェスチャ操作を行うということを明示的に伝える。具体的には、図の白色で描かれている円の内側に手の基準点が入るとジェスチャ認識が開始される。

3.2.1 全方位平行移動

搭乗者の手がグーであると識別された場合、Xtionの認識範囲の中心点の座標と現在の手の基準点の座標の差分を取り、ATの進行方向と移動する速さを決める。例えば、搭乗者が手を前に突き出すとATは前進し、搭乗者が手を右に動かすとATは右に平行移動する。この際、認識範囲の中心点から手の基準点が離れていればいるほどATの移動する速さは速くなる。なお、平行移動を行う際に、手の基準点の座標がXtionの認識範囲外にある場合とXtionの認識範囲の中心点付近にある場合、具体的には図の白色で描かれている円の内側の領域に含まれる場合、ATは平行移動を行わない。

また、ジェスチャ操作によって全方位平行移動を行う場合、ATの進行方向を固定する機能が存在する。この機能は、搭乗者が手を同じ位置に保持し続けることは負担であると考え、搭乗者が一度進みたい方向をATに伝えてしまえば、手が認識範囲に含まれていなくても搭乗者の進みたい方向にATが進み続けるようになるものである。通常のジェスチャ操作を行う際は、搭乗者の手がXtionの認識範囲から外れてしまうとATが停止するように設定されている。しかし、進行方向固定機能により進行方向が固定されると、搭乗者の手がXtionの認識範囲から出てしまっても固定された方向にATが進み続ける。この機能により、搭乗者が常に手を前に出している必要がなく、搭乗者の負担を減らすことが可能となる。なお、進行方向が固定されるための条件は、搭乗者が進みたい方向に一定時間手の位置を固定することである。また、この一度固定された進行方向を解除するためには、Xtionの認識範囲内で手をパーにすれば良い。この時、手がXtionの認識範囲の中心付近である必要はない。

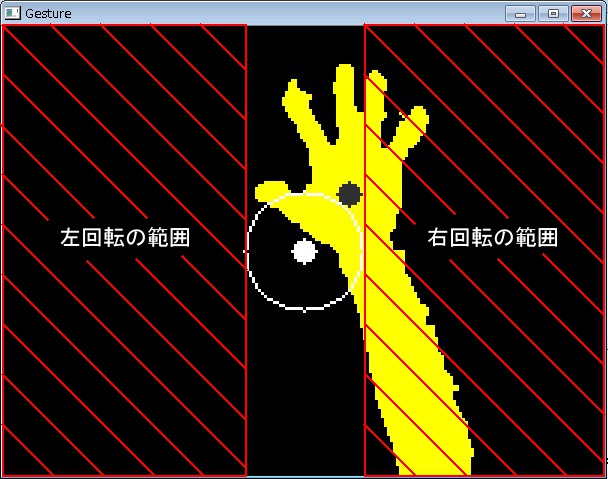

3.2.2 その場回転

搭乗者の手がパーであると識別された場合、Xtionの認識範囲の中心点の座標と現在の手の基準点の座標の差分を取り、ATの回転方向を決める。その場回転の方向は右回りと左回りの2通りある。ジェスチャによる操作の際は、現在の手の基準点の座標のx座標を判断の基準とする。図に示す左の範囲内に手の基準点がある場合はATが左回りにその場回転し、図の右の範囲内に手の基準点がある場合はATが右回りにその場回転する。それ以外の範囲に手の基準点の座標がある場合、ATは動かない。

図3.2: 回転方向が決められる範囲

また、先ほども述べたように手の形状をパーにすることで進行方向固定機能を解除することができる。

これらのジェスチャ操作を組み合わせることで、搭乗者はATを自由に動かすことが可能となる。ジェスチャによる操作方法が複雑になると、ジェスチャの利点である直感性が失われる可能性があるため、操作方法はできるだけ単純になるように努めた。

しかし、初めてATのジェスチャ操作を行う人にとって、自分のジェスチャ動作を正確に把握することは難しいと思われる。自分の動作がどのようにデバイスに認識され、その認識結果を元にATがどのように動いているのかといった情報を搭乗者に提示する必要性がある。そこで、本研究ではATのコンソールタブレットにその情報を提示し、搭乗者を支援する仕組みを考案した。以降でその仕組みについて述べる。

3.3 搭乗者への情報提示

ジェスチャ操作を行う搭乗者に対して、自分の期待するATの動きを正しく伝えられているのかといった情報のフィードバックを行うことは重要である。例えば、搭乗者がXtionの認識範囲外のところでジェスチャ操作を行おうとして手を動かしても、その情報がATに伝わることはなく、ATは動作しない。そのような場合、搭乗者には手がXtionの認識範囲外にある、といった情報が提示されるべきである。また、ATは周囲の環境情報を自身のセンサによって取得することができる。そのため、その情報を利用して搭乗者に周囲の障害物情報を提示することも可能である。

このような情報はATのコンソールタブレット上に表示され、搭乗者に対して情報提示が行われる。さらにこの情報提示は搭乗者にとって分かりやすいものである必要がある。そのために開発した仕組みについて以降で説明する

3.3.1 搭乗者のジェスチャの認識結果の情報提示

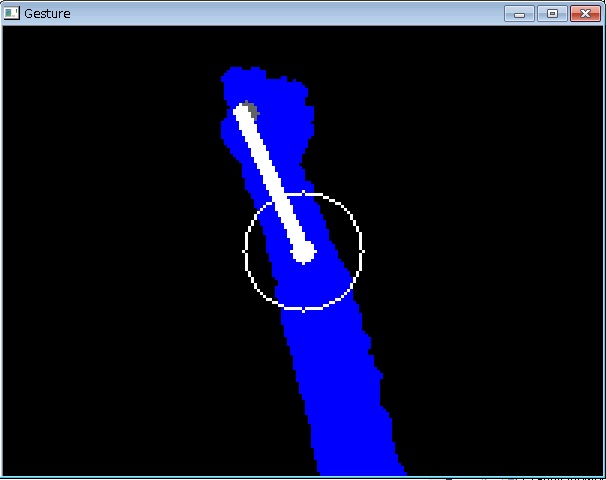

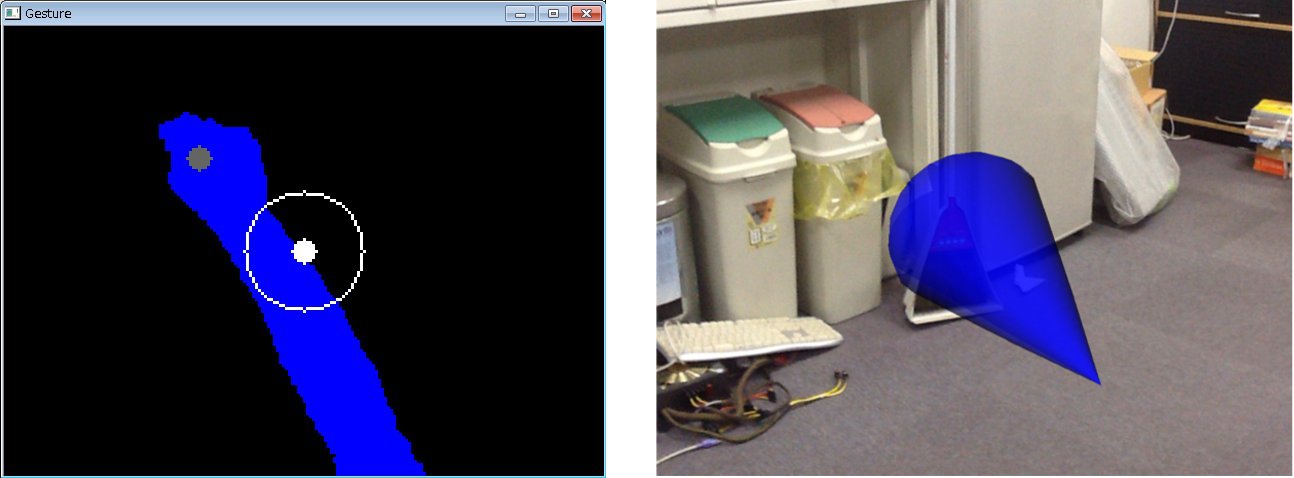

本研究では、搭乗者への情報提示として、ジェスチャ認識結果である図のような画像を用いた。この画像より、搭乗者は、自分の手をATがどのように認識しているのかを随時知ることができる。

図からも分かるように、搭乗者の手がグーの場合は搭乗者の手が青色で表示され、搭乗者の手がパーの場合は搭乗者の手が黄色で表示されるようになっている。さらに、搭乗者自身の手の基準点が現在どこにあるのかといった情報も同時に知ることができる。また、3.2節で述べたように、搭乗者の手の基準点がXtionの中心点付近になければATのジェスチャ操縦は開始されない。そこで、ジェスチャ操縦が開始されるための範囲を示すために図で示すようにXtionの認識範囲の中心を中心点とした円を描画し、搭乗者の手の基準点と同時に示すことにより、搭乗者がどの方向に手を動かせばジェスチャ操縦が開始されるのかを分かりやすく表示している。

また、3.2.1項で述べたように、ATのジェスチャ操縦には進行方向を固定する機能が搭載されている。そこで、現在進行方向が固定されているかどうかを搭乗者に伝えるために、図に示すような画像を用いる。

図のように、全方位平行移動中に進行方向が固定された場合は、進行方向が固定された瞬間の手の基準点とXtionの認識範囲の中心点を線で結ぶことによって情報提示を行う。Xtionの認識範囲の中心点から引かれたこの線の方向が固定された進行方向になっており、搭乗者が手を動かしてもこの線の向きは変わらない。なお、この線は進行方向が固定されている限り表示され続ける。

これらの情報はATのコンソールタブレット上に表示され、搭乗者はそのコンソールタブレットを見ながらジェスチャによる操縦を行うことができる。搭乗者が自身の手の状態を容易に確認しながらATを操縦することが可能となるため、よりスムーズなATのジェスチャ操縦を行うことができる。

図3.3: 進行方向が固定されていることを示す線

しかし、複数の被験者に、上記の方法で情報提示を行いながらATをジェスチャにより操縦してもらった結果、情報提示が行われているATのコンソールタブレットよりもジェスチャを行っている搭乗者自身の手の方を見てしまう被験者が複数名見受けられた。このことにより、搭乗者の手がXtionの認識範囲から外れてしまっても、搭乗者がそのことに気づかず、思うようにATを操縦できていない場面が何度か見受けられた。この実験結果の詳細については第4章で述べる。

そのため、本研究では上記の方法とは異なる別の情報提示の手法も考案して比較した。次節でその詳細について述べる。

3.4 アニメーショングラフィクスによる搭乗者への情報提示

搭乗者に自身の手の認識結果を提示するだけでは、情報提示を行うコンソールタブレットを搭乗者に見てもらえない場合があった。そこで、搭乗者に自身の手よりも情報提示を行うコンソールタブレットを見てもらう手法として、本研究では、アニメーショングラフィクスにより情報提示を行う仕組みを考案した。以下でその説明を行う。

3.4.1 搭乗者のジェスチャの認識結果の情報提示

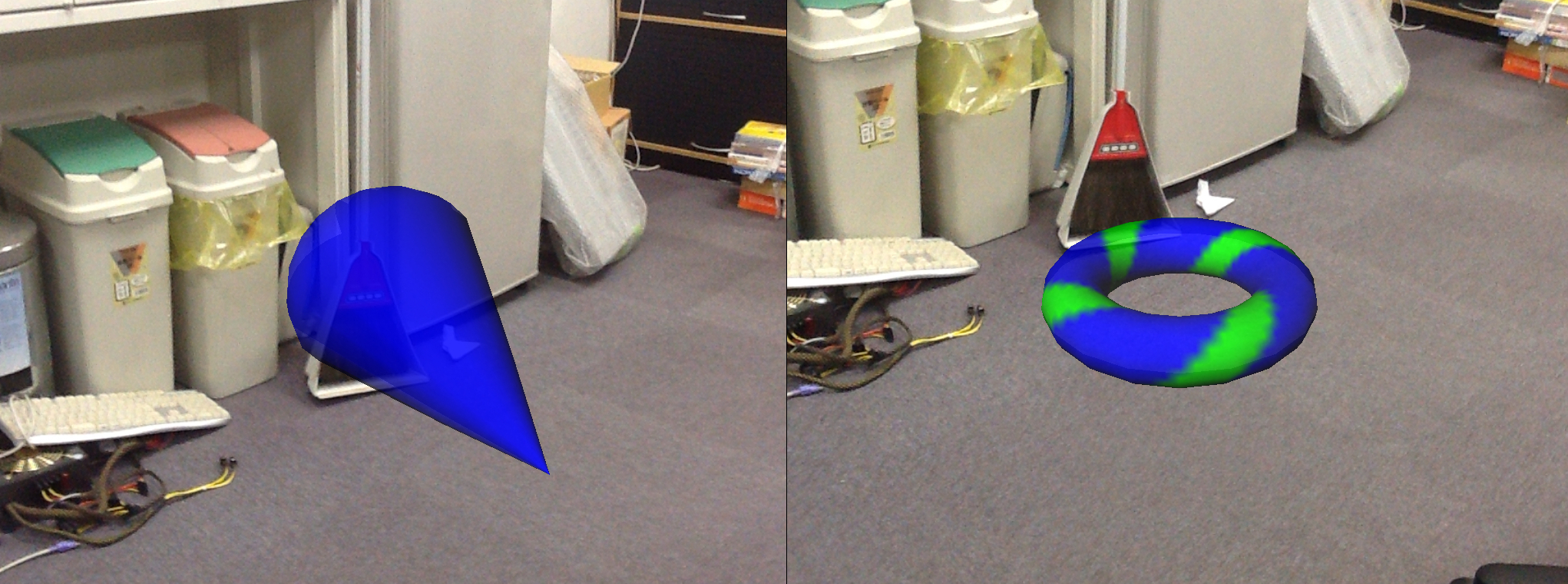

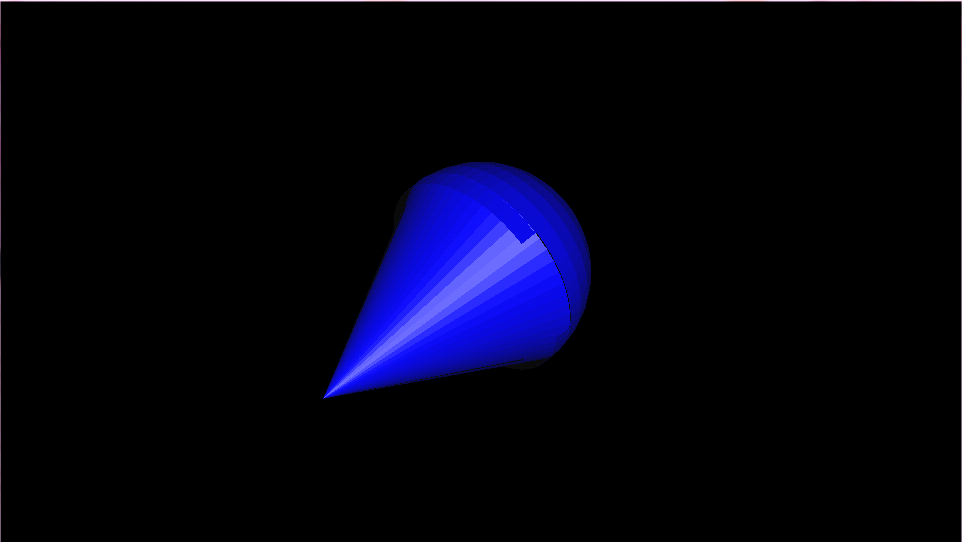

現在、自分のジェスチャがどのように認識されているのかといった情報を搭乗者に提示するために、本研究では図のような2つの形状のグラフィックオブジェクトを用意した。

図の左の図は搭乗者の手がグーと認識され、ATが平行移動していることを示し、右の図は搭乗者の手がパーと認識されてATがその場回転していることを示している。

これらの情報はコンソールタブレットの中心に表示されるオブジェクトの形状と色を変化させることによって提示する。平行移動の際は、搭乗者がATを移動させようとした方向をコンソールタブレットの中心の青色の円錐状のオブジェクトが指し示す。図の左の図では、搭乗者がATを右斜め後ろに移動させようとしていることを表している。一方、搭乗者がATをその場回転させようとしている際は、図の右の図のようにコンソールタブレット上のオブジェクトが青色と緑色の縞模様のリング状に切り替わる。アニメーションによりこのオブジェクトを回転させ、その回転方向によってその場回転を行っているATの回転方向を表現する。また、これらの2つの形状のオブジェクトの切り替えもアニメーションにより連続的に変化させて表示する。

図3.4: ATの動作情報を伝える2つのグラフィックオブジェクト

また、3.2.1項で述べたようにATのジェスチャ操縦には進行方向を固定する機能が存在する。そこで、進行方向が固定されているかどうかの情報を搭乗者に提示する方法として、図に示す方法を用いる。

図3.5: 平行移動時に進行方向が固定されているかどうかを提示する

図のように、進行方向が固定されているかどうかは円錐状のオブジェクトの色を青色から緑色に変化させることで行う。

さらに、図に示すように、これらの2つの形状のオブジェクトの色は搭乗者の手がXtionの認識範囲の中心点から離れるに従って徐々に透明化されていく。ただし、平行移動時で進行方向が固定され、表示されている円錐状のオブジェクトの色が図のように緑色に変化している場合、オブジェクトの色の透明化は行われない。

図3.6: オブジェクトの透明化

この機能により、搭乗者は自分の手がXtionの認識範囲から出ようとしているという情報を知ることができ、3.3.1項で述べたように、搭乗者の手が知らず知らずのうちにXtionの認識範囲から出てしまい、搭乗者がXtionの認識範囲外でジェスチャ操作を行おうとして手を動かす、という状況を防ぐことが可能になる。ちなみに、搭乗者の手がXtionの認識範囲から外れてしまった場合、これらのオブジェクトはATのコンソールタブレット上に表示されない。ただし、進行方向が固定されている場合のみ、搭乗者の手がXtionの認識範囲外にあったとしても、コンソールタブレット上には図の右の図に示す緑色の円錐状のオブジェクトが表示され続ける。

これらのオブジェクトの映像は、ATのコンソールタブレット内臓のカメラによって撮影されているATの前方の風景に重ねて表示される。そのため、搭乗者は前方の風景を見ながらATの動作を知ることができる。

3.4.2 障害物の情報提示

搭乗者が自分のジェスチャ操作の確認のために、ATのコンソールタブレットに注目しすぎて、ATの周囲の状況を正しく認識できずに誤って障害物に向かってATを移動させようとする場合もあり得る。2.5節で述べたように、ATは補助走行機能により、自動的に障害物を回避し、ATと障害物が衝突することはないが、搭乗者の気付かないうちにATが障害物に向かって移動するような状況はできるだけ避けた方が良い。そこで、コンソールタブレット上にATの周囲のどの方向に障害物があるのかといった情報も表示し、搭乗者への情報提示を行う。

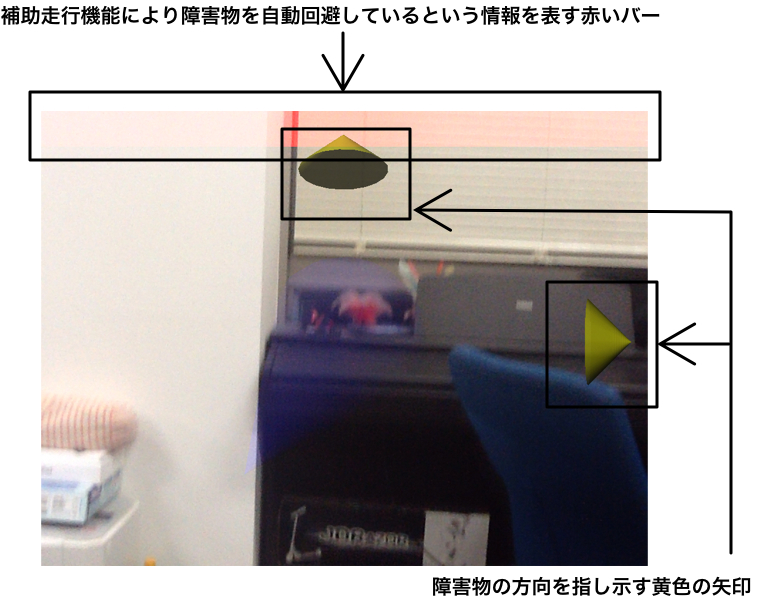

ATはレーザレンジセンサにより周囲の障害物までの距離情報を取得している。レーザレンジセンサより得られた情報を元に、ATの周囲の一定距離内に障害物があれば、そのおおまかな方向をコンソールタブレット上に表示して搭乗者に障害物に関する情報を伝える。図に障害物の方向を提示している様子を示す。

図3.7: 障害物情報の提示

図は、ATのコンソールタブレットの画面の上と右に、その方向に障害物があることを示す黄色の円錐が表示されている状態を表している。上下に表示される黄色の円錐は向きが傾いており、それぞれ前と後ろに障害物がある際に表示される。また、左右の円錐はATの左右に障害物がある場合に表示される。搭乗者はこの黄色の円錐により、周囲に障害物があるかどうかを知ることができる。

また、ジェスチャによるATの操縦は2.5節で述べた補助走行機能を用いている。そのために、搭乗者の進みたい方向に障害物がある場合、ATは自動的にその障害物を回避して走行しようとする。しかしそのような場合、ATが搭乗者の意図とは異なった動きをするために搭乗者はATの動きに困惑するかもしれない。そこで、ATのコンソールタブレット上にATが補助走行機能により障害物を回避している最中であるという情報も提示する。この情報提示は図の上部にあるような赤いバーを点滅させながら表示することによって行う。この赤いバーはATの進行方向によってコンソールタブレット画面の上下左右に表示される。図のようにコンソールタブレット画面の上部に赤いバーが表示された場合はATが前方の障害物を自動回避していることを表し、赤いバーがコンソールタブレット画面の右に表示された場合はATが右側にある障害物を自動回避していることを表している。

これにより搭乗者は、ATが補助走行により障害物を自動回避しているという情報を得ることができる。よって、搭乗者の意図と反してATが動いたとしても戸惑うことなくATの操縦を続けることが可能となる。

3.4.3 搭乗者の手の位置の情報提示

3.2節で述べたように、Xtionに映し出される搭乗者の手の基準点が、図に示す円の内側に入らなければジェスチャ操作は開始されない。そのため、搭乗者がXtionの認識範囲内に手をかざした時、現在の手の基準点がXtionの認識範囲の中心点からどの程度離れているのかといった情報も搭乗者に提示する必要性がある。

そのため、搭乗者がどの方向に手を動かせばATをジェスチャによって操縦可能になるのかといった情報提示を、図のような画像をATのコンソールタブレットに表示することによって行う。

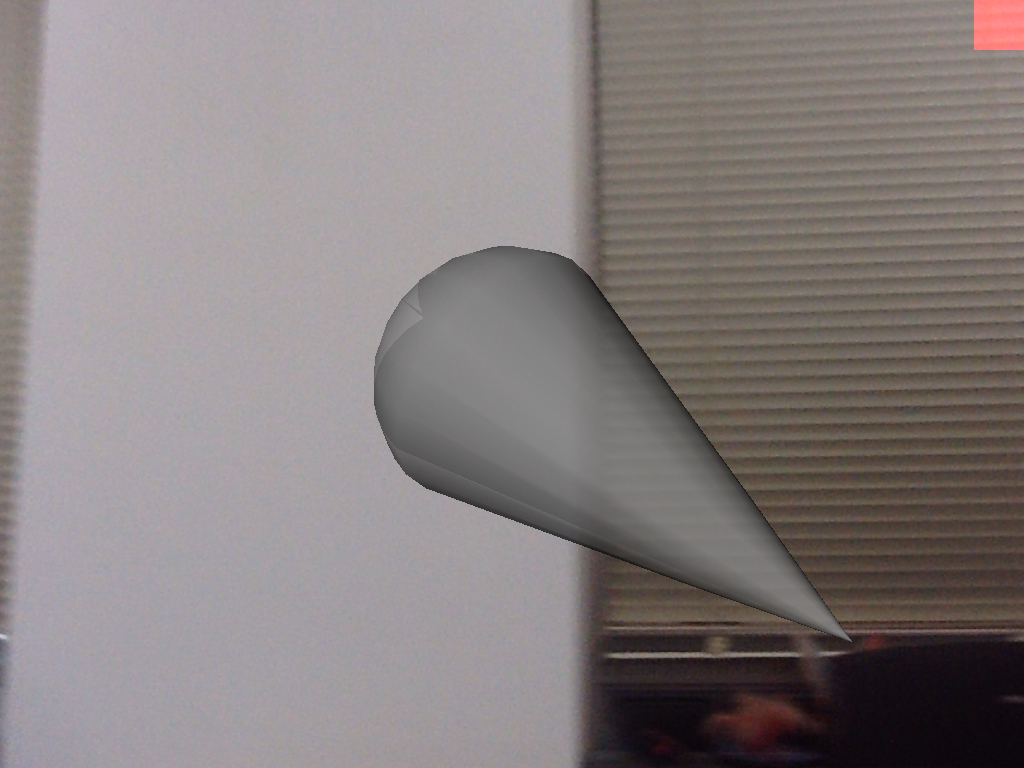

図3.8: Xtionの認識範囲の中心点からのずれ

図から分かる通り、搭乗者の手の形状がグーで、ATが全方位平行移動をしている際に表示されるオブジェクトと同じ形状のオブジェクトを用いる。平行移動の際のオブジェクトと異なる点は表示されるオブジェクトの色が異なる点である。ATが平行移動をしている場合は円錐型のオブジェクトが青色で表示されるが、搭乗者の手の基準点がまだ一度も図で示す円の内側に入っておらず、ATのジェスチャ操作がまだ始まっていない場合は円錐型のオブジェクトが灰色で表示される。

図の灰色の円錐型のオブジェクトが指し示す方向によって、搭乗者の手の基準点がXtionの認識範囲の中心点から見てどの方向にずれているのかを表し、オブジェクトの高さによって搭乗者の手の基準点がXtionの中心点からどの程度離れているのかを表している。

ちなみに、図は搭乗者の手がXtionの中心点から見て右斜め後ろにずれていることを表している。

表にて、ATのコンソールタブレット上に表示されるオブジェクトの違いを示す。

表に示したように、搭乗者の手の基準点とXtionの認識範囲の中心点のずれを表すオブジェクトは搭乗者の手の形状がグーとパーのどちらに識別されても、円錐状のオブジェクトで表示される。灰色の円錐状のオブジェクトは搭乗者の手の基準点が図の白色で描かれている円の内側に入ると表示されなくなり、代わりに、搭乗者の手の形状に応じたATの動作に対応するオブジェクトが表示されるようになる。

搭乗者の手がXtionの認識範囲から外れた場合、進行方向が固定されている場合を除いてコンソールタブレット上にオブジェクトは表示されなくなる。その後、搭乗者の手が再度Xtionの認識範囲内に現れた場合、再び搭乗者の手の基準点がXtionの認識範囲の中心点からどの程度ずれているのかを表す灰色の円錐状のオブジェクトが表示されるようになる。

2.4節で述べたように、ATの操縦は図に示すコントローラによっても行うことができる。このアニメーショングラフィクスにより情報提示を行う手法では、ジェスチャだけではなくコントローラでATを操縦している際も、コンソールタブレット上で搭乗者に対して情報提示を行う。

この際にコンソールタブレット上に表示される情報は図に示した障害物に対する情報のみであり、ジェスチャ認識の結果を表すオブジェクトは表示されない。

本章では、ATのジェスチャインタフェースと搭乗者への情報提示の手法について述べた。ジェスチャによるATの操縦は搭乗者の手の位置とXtionの認識範囲の中心点を比較することで行われる。また、搭乗者に自身のジェスチャがどのように認識されているのかについてフィードバックを行うことや、周囲の障害物情報を示すことで、スムーズにジェスチャ操縦を行えるように工夫した。次章では本章で説明した2つの情報提示の手法を用いた比較実験について述べる。

4 評価実験

ジェスチャによってATを操作する際は、搭乗者のジェスチャに応じた適切なフィードバックが搭乗者に対して行われる必要がある。ATが搭乗者の意図した動きをしているのか、周囲に障害物があるのか、搭乗者の手はXtionの認識範囲内にあるのか、などといった情報は搭乗者がスムーズにジェスチャ操縦を行うために有用である。

そこで本研究では、搭乗者に情報提示を行う手法として、ジェスチャ認識画面を見せることで情報提示を行う手法とアニメーショングラフィクスにより情報提示を行う手法の2通りの手法を考案し、その比較実験を行った。本章では実験内容と実験結果を説明し、その考察を述べる。

4.1 実験内容

本実験は、2011年11月23日に愛・地球博記念公園で開催されたクルマ未来博2011の会場で行った。被験者は過去にATに乗った経験のない一般の人たちである。図のようなスペースを用意し、被験者に自由にATを操縦してもらった。被験者には、あらかじめATのジェスチャによる操縦方法について説明してある。

図4.1: 実験で使用したスペース

本実験では、搭乗者が自由にATを移動させることができるようなスペースを用意し、また、2.5節で説明した補助走行機能により障害物と衝突することなく安全に移動できることを確認するために、障害物を設置した。

被験者にはジェスチャによってATを操縦しながらこのスペース内を自由に移動してもらう。この際の搭乗者に対する情報提示の手法として図のような2通りの画面を用いる。この画面はATに取り付けられているコンソールタブレット上に表示される。なお、被験者1人に対して図の画面のどちらか一方のみを提示する。

図4.2: 実験で使用した情報提示画面

図の左の画面が搭乗者のジェスチャ認識処理過程の画面をそのまま提示している画面であり、図の右の画面が搭乗者のジェスチャ認識結果を元にアニメーショングラフィクスで情報提示を行う画面である。今回の実験では図の左の画面でATを操縦した被験者が5名、右の画面でATを操縦した被験者が10名であった。

その後、被験者にアンケートに答えてもらい、図のどちらの画面の方が情報提示の手法として優れているのかを調査する。以下にアンケートの設問を記述し、それぞれの意図について述べる。

-

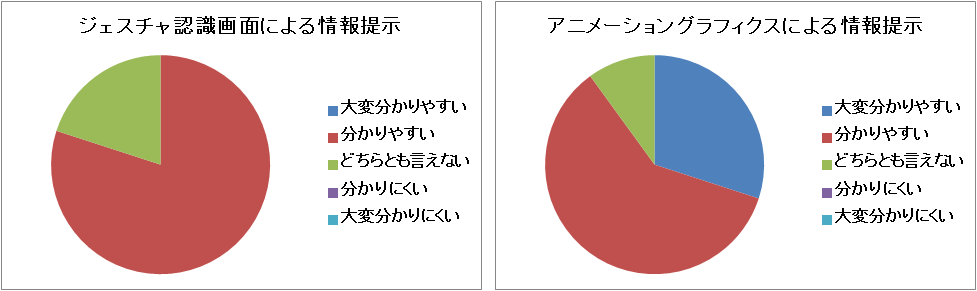

設問1 ATの動作が分かりやすく表示されていましたか?

大変分かりやすい、分かりやすい、どちらとも言えない、分かりにくい、大変分かりにくい、という5段階で評価してもらった。

被験者のジェスチャによるATの動作を正しく把握できているのかを調査する。全方位平行移動時に進行方向が固定されているかどうかといった情報の提示が分かりやすいかどうかを調査するために用意した。

-

設問2 行っているジェスチャが分かりやすく表示されていましたか?

この設問の評価軸は設問1と同じものとなっている。

被験者のジェスチャがATにどのように認識されているのか容易に知ることができるかを調査する。被験者の手がグーとパーのどちらに認識されているのか、Xtionの認識範囲のどのあたりにあるのかといった情報の提示が分かりやすいかどうかを調査するために用意した。

-

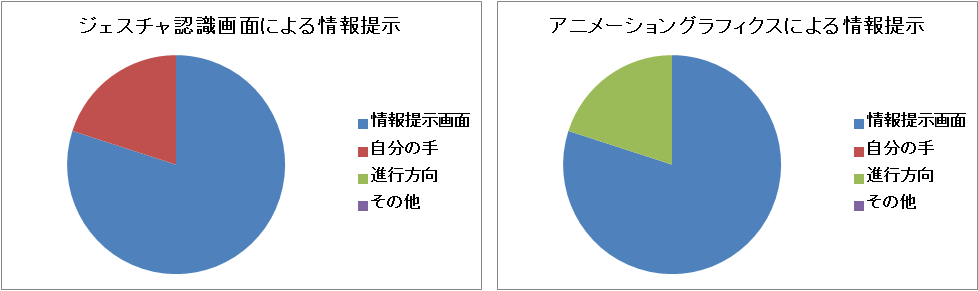

評価軸として、ATのコンソールタブレット、被験者自身の手、ATの進行方向、その他の4つを用意した。

被験者が自身の手ばかりを見て、情報提示画面を見ないことが想定されるのでこの設問を用意した。

設問3 ATの操作中に主にどこを見ていましたか?

-

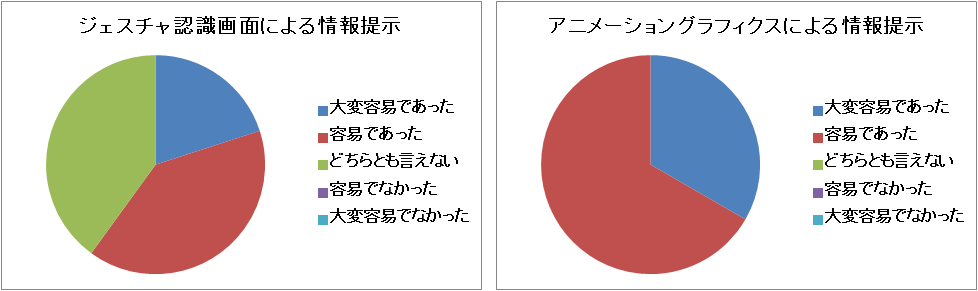

設問4 ジェスチャを覚えることは容易でしたか?

大変容易であった、容易であった、どちらとも言えない、容易でなかった、大変容易でなかった、という5段階で評価してもらった。

コンソールタブレット上で情報提示を行うこととは別に、ATを操縦するためのジェスチャ動作が被験者にとって分かりやすい自然な動作であったのかを調査するために用意した。

-

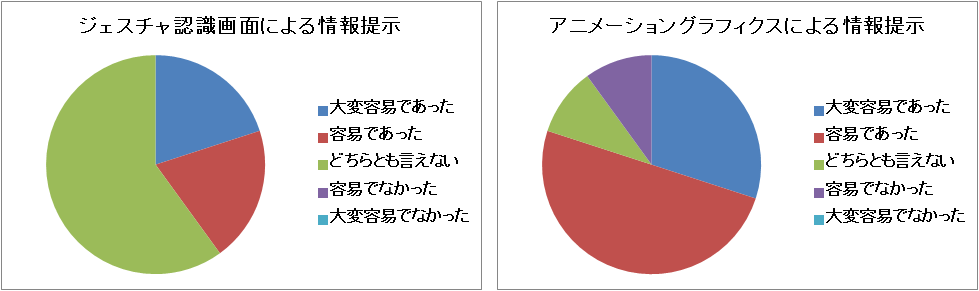

設問5 ジェスチャによる操作は容易でしたか?

この設問は設問4と同じ評価軸で評価してもらった。

コンソールタブレット上で情報提示を行うこととは別に、ATをジェスチャで操縦することが被験者にとって容易なものであったかどうかを調査するために用意した。

また、これらの設問とは別に自由記述欄を設けて、被験者に何か気がついた点があれば記述してもらった。

4.2 結果と考察

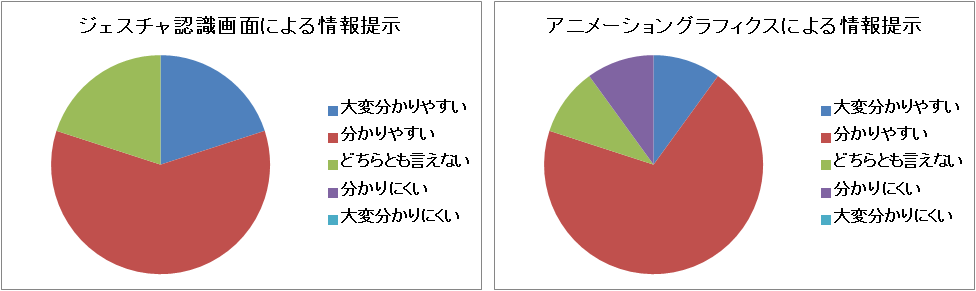

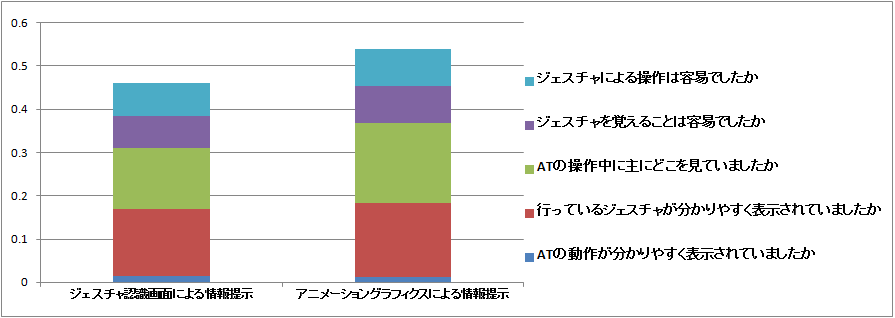

実験結果を図、、、、に示す。設問ごとの解答の割合を2通りの情報提示手法についてそれぞれ分けて示している。

図4.3: 設問1.ATの動作が分かりやすく表示されていましたか?

図4.4: 設問2.行っているジェスチャが分かりやすく表示されていましたか?

図4.5: 設問3.ATの操作中に主にどこを見ていましたか?

図4.6: 設問4.ジェスチャを覚えることは容易でしたか?

図4.7: 設問5.ジェスチャによる操作は容易でしたか?

次に、実験結果について述べる。

4.2.1 設問1について

図に示す、設問1の結果について述べる。この図から分かるように、ジェスチャ認識の画面を提示した方が良い結果となった。アニメーショングラフィクスによる情報提示の場合、ATの動作に関する情報提示が分かりにくかった、と答えた被験者も見受けられた。

しかし、自由記述欄に、ATの動作については画面を見なくても実際に動いているATから感じ取ることができる、という旨の記述があり、情報提示手法の優位性をこの設問のみで評価することはできないと考えられ、他の評価観点と総合して判断する必要がある。

4.2.2 設問2について

図に示す設問2の結果について述べる。図より、アニメーショングラフィクスよって情報提示を行った場合、大変分かりやすいと答えた被験者が複数名見受けられたが、ジェスチャ認識画面によって情報提示を行った場合は大変分かりやすいと答えた被験者は見受けられなかった。これは、アニメーショングラフィクスを用いて情報提示を行う場合に、自分のジェスチャがどのように認識されて、ATがどの方向に平行移動しようとしているのか、もしくは左右のどちら回りにその場回転を行おうとしているのかを分かりやすく提示しているためだと考えられる。

これより、ジェスチャ認識画面によって情報提示を行うよりもアニメーショングラフィクスによって情報提示を行う方が、搭乗者のジェスチャが分かりやすく表示されていたと言えるため、情報提示の手法として効果的だと言える。

4.2.3 設問3について

図に示す設問3の結果について述べる。ジェスチャ認識画面によって情報提示を行った場合、ジェスチャを行っている自身の手に注目してしまい、情報提示画面を見ていない被験者が見受けられた。この被験者は自身の手がXtionの認識範囲から外れても、そのことに気付かず、ATをスムーズに操縦できていなかった。一方、アニメーショングラフィクスによって情報提示を行った場合、ATのコンソールタブレットよりも進行方向を見ていたと答えた被験者が見受けられた。これは、被験者がジェスチャ操作に慣れてきて情報提示画面を見なくてもスムーズにATの操縦ができるようになったためだと考えられる。ただし、情報提示画面を全く見ないという訳ではなく、ジェスチャ操作の補助として情報提示画面を見ることもあり、進行方向ばかりを見るのではないということである。

これより、ジェスチャ認識画面を用いた情報提示手法では、搭乗者が情報提示画面に注目せず、搭乗者に情報が伝わらないこともあるため、アニメーショングラフィクスを用いた情報提示手法の方が搭乗者に対して確実に情報提示を行うことができると言える。

4.2.4 設問4について

図に示す設問4の結果について述べる。図より、ジェスチャ認識画面を用いて情報提示を行うよりも、アニメーショングラフィクスを用いて情報提示を行った方が操縦のためのジェスチャを覚えることがより容易であるとの結果が得られた。これは、被験者にとって自身のジェスチャとATの動作との対応がアニメーショングラフィクスを通してより理解しやすかったためだと考えられる。

また、4.2.3項でも述べたように、アニメーショングラフィクスを用いた情報提示を行った場合、情報提示画面よりも進行方向を見ていた被験者もいたことから、アニメーショングラフィクスによる情報提示はATの操縦のためのジェスチャ動作の習熟に対しても効果的なものであると言える。

4.2.5 設問5について

図に示す設問5の結果について述べる。図より、ジェスチャ認識画面を用いて情報提示を行うよりも、アニメーショングラフィクスを用いて情報提示を行う方がよりジェスチャ操作を容易に感じるという結果が得られた。これは、被験者に対して、アニメーショングラフィクスによる状況に応じた情報提示が行われることで、被験者がその情報をジェスチャ操作に反映させ、より効率的にジェスチャ操作を行うことができたためだと考えられる。

これより、ジェスチャ認識画面を用いて情報提示を行うよりも、アニメーショングラフィクスを用いて情報提示を行う方がより良い情報提示を行うことができたと言える。

4.2.6 総合評価

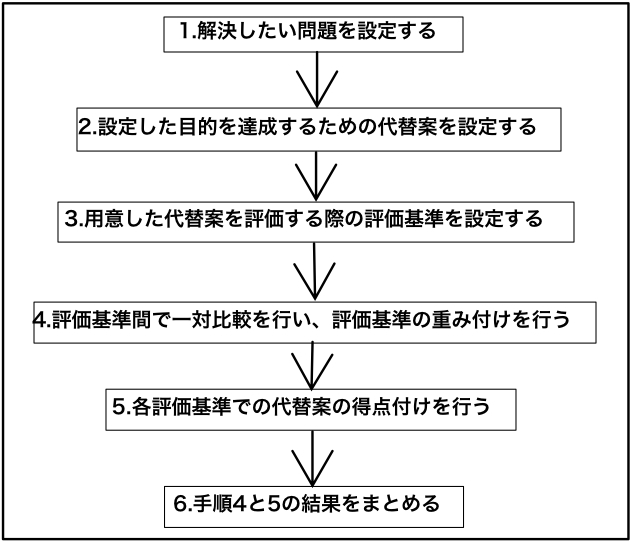

前述の各設問をまとめて評価する手法として、今回の実験では階層分析法を用いた。階層分析法とは複雑な状況下で意思決定を行う際に用いられる構造化法の1つである。今回の実験では、アンケートの各設問がそれぞれ独立した評価軸とは言えず、互いに関連しているためにこの評価手法を用いた。図に今回行った階層分析法の流れを示す。

図4.8: 階層分析法の流れ

-

階層分析法によって解決したい問題を設定する。今回の実験では、「搭乗者への情報提示手法の決定」がこの問題となる。

-

手順1で設定した問題を解決するための代替案を用意する。今回の実験では「ジェスチャ認識画面による情報提示」と「アニメーショングラフィクスによる情報提示」が代替案として設定されている。

-

手順2で用意した代替案を評価する基準を設定する。今回の実験ではアンケート項目の5つの設問がこの評価基準となる。

-

評価基準間での重み付けを行うために、各評価基準間でそれぞれ一対比較を行う。一対比較とは比較対象のうちの2つを1組として、どちらがより良いかを比較判断していく手法である。表に今回行った実験で使用した評価基準間の一対比較を示す。

表のように、設問を2つ選び出しどちらが重要であるのかを決定する。今回の実験では、ATの動作は情報提示画面よりもATの実際の動きそのものから判断した被験者が複数名見受けられたため、設問1の重要度を低くした。また、被験者の行っているジェスチャの認識状況に関する情報提示についての設問と、被験者がATを操縦している際に主にどこを見ていたのかという設問を同程度の重要度と見なした。これは、被験者のジェスチャがどのように認識されているのかを伝えることは明らかに重要であると言えるが、被験者が情報提示を行っているコンソールタブレットを見ていなければ、適した情報提示ができないと考え、被験者がATの操作中にどこを見ていたのかという情報も重要視したためである。

この結果を基に、表の一対比較値を用いて評価基準間の重み付けを行う。表の値は参考文献の内容を基に決定した。重み付けの結果を表に示す。

-

アンケート結果を基に、代替案の各評価基準に対する点数付けを行う。今回の実験では、各評価基準について最高得点を5、最低得点を1とした。設問1では、「大変分かりやすい」が5点、「分かりやすい」が4点、「どちらとも言えない」が3点、「分かりづらい」が2点、「大変分かりづらい」が1点となる。なお、設問3については「情報提示画面」を3点、「自分の手」を1点、「進行方向」を5点とし、「その他」については適宜点数をつけることにした。これは、搭乗者が自身の手ばかりを見ていると、適した情報提示を行うことができないと考えたためと、進行方向を見るということは、被験者が情報提示画面の補助により、ATのジェスチャ操作を早く習熟することができたと考えたからである。

図4.9: 階層分析法による実験の評価

図より、ジェスチャ認識画面を用いて情報提示を行うよりも、アニメーショングラフィクスを用いて情報提示を行う方がより良い情報提示の手法と言える。

また、設問4と5の結果より、適切な情報提示が行われると、ジェスチャを用いたATの操縦をより習熟しやすくなると考えられる。また、アニメーショングラフィクスにより、被験者に対して、自身のジェスチャとそれに対応するATの動きを適切に結び付けられる情報提示を行うことができたと考えられる。

ただし、いくら情報提示画面で適切な情報提示を行ったとしても、被験者がその情報提示画面を見なければ情報提示を行う意味がない。設問3の結果より、ジェスチャ認識画面を用いた情報提示の場合は、自身の手に注目してしまい、情報提示画面を見なかった被験者が見受けられたが、アニメーショングラフィクスを用いた情報提示の場合は、自身の手に注目してしまう被験者は見受けられなかった。これにより、アニメーショングラフィクスによる情報提示手法が被験者の注目を集める手段として有効であると考えられ、情報提示を行う手法として効果的であると考えられる。

本実験から、ジェスチャ認識画面を用いた情報提示よりも、アニメーショングラフィクスを用いた情報提示の方が情報提示手法として効果的であることが確認された。また、ジェスチャ操作を習熟する点においてもアニメーショングラフィクスを用いた情報提示手法の方が有効であることが確認された。

次に、今回の実験から確認された現状の問題点およびシステムを改良する方法について述べる。

4.3 現システムの問題点およびその改良法

4.3.1 ジェスチャ認識アルゴリズムの改良

搭乗者がジェスチャによってATをその場回転させたい場合は、手の形状をパーにし左右のどちらかに手を平行移動させることで行う。しかし、今回の実験中に手を平行移動させずに手をパーにしたまま手首を曲げることでその場回転を行おうとする被験者が複数名見受けられた。あらかじめATのジェスチャ操縦方法は伝えてあったにも関わらず、このような被験者が見受けられたということは、被験者によって直感的な操縦のためのジェスチャが異なることを示している。

同じようなジェスチャを行った被験者が複数名見受けられたため、手首を曲げるジェスチャによってもATのその場回転を行えるようにする必要があると考えられる。また、今後このようなことが起こることも十分考えられるため、その新しいジェスチャが直感にあったものであるかを吟味しつつ、直感的だと判断された場合にはジェスチャ認識アルゴリズムに新しく組み込まれていく必要があると考えられる。その方法として、ジェスチャ認識のプログラムに直接修正を加えることや、機械学習により特定のジェスチャを識別できる仕組みを追加することなどが挙げられる。

4.3.2 情報提示手法の改良

今回の実験では、情報提示画面をATのコンソールタブレットに表示させることで行った。しかし、いくら適切な情報提示が行われているとは言え、搭乗者がコンソールタブレットばかりに注目しているのは問題である。周囲の障害物に対する情報も提示しているが、搭乗者が自ら周囲の情報を確認し、適宜ジェスチャ操縦に反映させていくことが重要であると考える。アニメーショングラフィクスによる情報提示手法の際は、コンソールタブレットに内蔵されているカメラを使用してATの前方の映像も提示しているが、それだけでは不十分である。

この問題を解決する方法として、透過型のヘッドマウントディスプレイを用いて情報提示を行う手法が考えられる。この手法により、搭乗者が見ている風景に重ねて情報提示を行うことが可能になり、より効率的な情報提示を行うことができると考えられる。これについては次章でより詳しく述べる。

5 展望

第3章では本研究で開発したATのジェスチャ操縦の仕組みと搭乗者に対する情報提示の手法について説明した。また、第4章では本研究で考案した搭乗者に対する情報提示手法の評価実験について述べた。これらの内容を踏まえ、本章では開発したシステムの改良策および応用例について述べる。

5.1 搭乗者に対する情報提示手法の改良

4.3.2項でも述べたが、搭乗者が情報提示画面であるコンソールタブレットばかりに注目するのは問題である。これにより、搭乗者の周囲に対する注意力が低下してしまう恐れがある。その解決案として、図に示す透過型のヘッドマウントディスプレイを用いて情報提示を行う手法が考えられる。

図5.1: 透過型ヘッドマウントディスプレイ(左)と装着してATに搭乗した様子(右)

これにより、搭乗者が見ている風景に情報提示画面を重ねて表示することが可能となるので、搭乗者がどこを向いていても常に情報提示画面を見てもらうことが可能となる。そのため、より効率的に情報提示を行うことが可能になると考えられ、現在、この透過型ヘッドマウントディスプレイを用いた情報提示の研究を進めている。

しかし、この透過型ヘッドマウントディスプレイにもいくつかの問題点が挙げられる。例えば、ATが左後ろに向かって平行移動している場合、透過型ヘッドマウントディスプレイには、搭乗者の見ている風景に重ねて、図のような映像が映し出される。なお、透過型ヘッドマウントディスプレイの画面には、3.4節で述べたアニメーショングラフィクスを用いた情報提示手法の場合と同じ画像が映し出される。

図5.2: 透過型ヘッドマウントディスプレイに映し出される映像

搭乗者が前方を向いている時はATの進行方向を正しく搭乗者に伝えられると考えられる。しかし、現在開発中の仕組みでは、搭乗者が横を向いた際も図と同じ映像が映し出されるため、搭乗者に対して直感的で分かりやすい情報提示が行われているとは言えない。搭乗者の直感に合った仕組みとしては、搭乗者の向いている方向に従って表示されるグラフィックオブジェクトの向きを変更する必要があると考えられる。現在開発中の仕組みでは、搭乗者がどこを向いているのかという情報を取得することができないため、3軸角度センサなどを用いて搭乗者の向きを取得できるように拡張していく必要があると考えられる。

5.2 ジェスチャインタフェースのその他の応用

これまでに行われてきたジェスチャインタフェースに関する研究として、手による自然なジェスチャで部屋の中にある家電製品を操作する研究がある。この研究は、部屋の中に取り付けられた2台のカメラを用いてジェスチャ認識を行い、部屋の中にある家電製品を部屋の中の任意の位置からジェスチャによって操作するというものである。これまでのジェスチャに関する研究では、ジェスチャ認識可能な場所がジェスチャ認識デバイスの正面に限られているものが多かったが、この研究はジェスチャ認識可能な範囲を広げるための工夫が施されている。

ここで、このような研究と本研究室で開発しているATの技術を組み合わせることで、ジェスチャ認識の環境ごと移動し、周辺機器と通信を行うことで、あらゆる機械を一つのジェスチャ認識デバイスで操作可能にする新しい仕組みが実現できると考えられる。

この仕組みを用いると、ATの搭乗者はATに乗りながらテレビの映像を切り替えることや、エレベータの操作を行うことが可能となる。また、周辺の機械の操作はATに装備されているジェスチャ認識デバイスを使用したジェスチャで行うため、ボタンやリモコンなどで機械を操作するよりも直感に合った動作で対象となる機械を操作可能となる。

現在このような仕組みを実現させるべく、研究を進めており、その一つの例として、ATの周囲を走行してATのセンサを補完するSUV (Small Unmanned Vehicle)をジェスチャで操作可能にする仕組みを実現した。

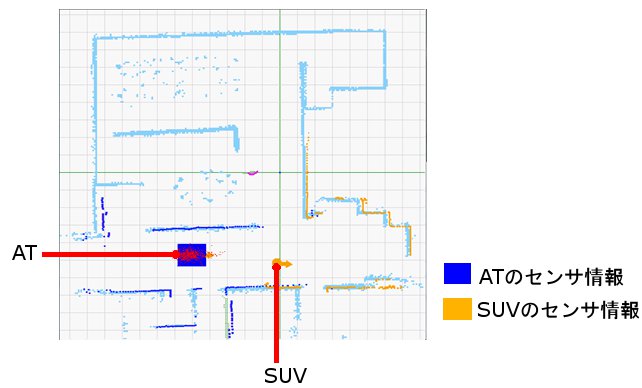

図5.3: 2種類のSUV(左:RGB-Dカメラ搭載, 右:RGB-Dカメラ非搭載)

SUVとはATの進行経路を先行して走行し、人間などの障害物が近付いてこないかどうかを検知する無人の移動体である。SUVにはATと同様にレーザレンジセンサが搭載されており、周囲の障害物までの距離情報を取得することができる。SUVは事前に環境を走行し、レーザレンジセンサの値を用いることでその環境の地図を生成し、その地図を用いることで自己位置推定を行う機能を持つ。また、地図とその時点でのレーザレンジセンサの値を比較することで人間などの障害物を認識する機能も持つ。ATはSUVと通信を行うことで、AT自身のセンサが届かない場所についても障害物の情報を知ることが可能となり、より安全で効率的な移動を行うことができる。図にATが自身のセンサ情報とSUVからのセンサ情報を統合している図を示す。オレンジ色の点はSUVが取得したセンサ情報を表しており、青色の点はATの取得したセンサ情報を表している。

通常、SUVはATの走行経路を先行して走行し、障害物に関する情報をATに送信している。また、SUVにはRGB-Dカメラ(カラー画像と深度情報を同時に取得できるカメラ)が搭載されているものもあり、通常の障害物と人間を識別することも可能となる。この情報もATに送信することで、ATはより安全な走行を可能としている。

図5.4: ATのセンサ情報とSUVのセンサ情報の統合

しかし、ATの搭乗者がSUVを操作し、任意の場所についての情報を取得したい場合も考えられる。そこで、ジェスチャによって周囲の機械を操作する仕組みの一つの例として、SUVを操作する仕組みを実現した。以降でその詳細について述べる。

5.2.1 ジェスチャによるSUVの操作

SUVのジェスチャ操作もATに取り付けられているXtionを用いて行う。そのため、ジェスチャによって操作する対象を切り替える必要がある。この操作対象の切り替えもジェスチャによって行う。本研究では、操作対象を切り替えるためのジェスチャとして、手をXtionの前で横切らせるジェスチャを用いる。すなわち、ジェスチャでATを操縦している際に、搭乗者がXtionの前で手を横切らせるとジェスチャによる操作の対象がATからSUVに切り替わる。なお、ジェスチャによる操作の対象がATでなくなった場合、ATは停止する。

SUVの動作には、前後の平行移動とその場回転の2通りがある。SUVをジェスチャによって操作する場合も、ATをジェスチャで操縦する場合と同様に手の形状を識別した後に、手の基準点とXtionの認識範囲の中心点の差分を求めることで行う。手の形状がグーだと識別された場合は、搭乗者がSUVを前後に平行移動させようとしていると見なす。その後、手の基準点のy座標を判断の基準として、図に示した範囲に従ってSUVの動作を決定する。

一方、手の形状がパーだと識別された場合は、搭乗者がSUVをその場回転させようとしていると見なす。SUVをその場回転させるジェスチャはATをジェスチャ操作する際と全く同じ動作で行う。3.2.2項で述べたように手の形状をパーにし、図に示した範囲に手の基準点がある場合、その範囲に従って左右のどちら方向に回転するのかを決定する。

また、あるSUVをジェスチャ操作している際に搭乗者がXtionの前で手を横切らせるとジェスチャによる操作の対象がそのSUVから他のSUVあるいはATなどに切り替わる。

図5.5: 平行移動を行う範囲

5.2.2 搭乗者への情報提示

SUVをジェスチャによって操作する際も、搭乗者のジェスチャがどのように認識されているのかといった情報を搭乗者に提示する。情報提示には3.4節で述べたようにアニメーショングラフィクスを用いる。この情報は5.1節で述べた透過型ヘッドマウントディスプレイに表示される。図で示したように、SUVを平行移動させようとしている場合は円錐状のオブジェクトが表示され、SUVをその場回転させようとしている場合はリング状のオブジェクトが表示される。

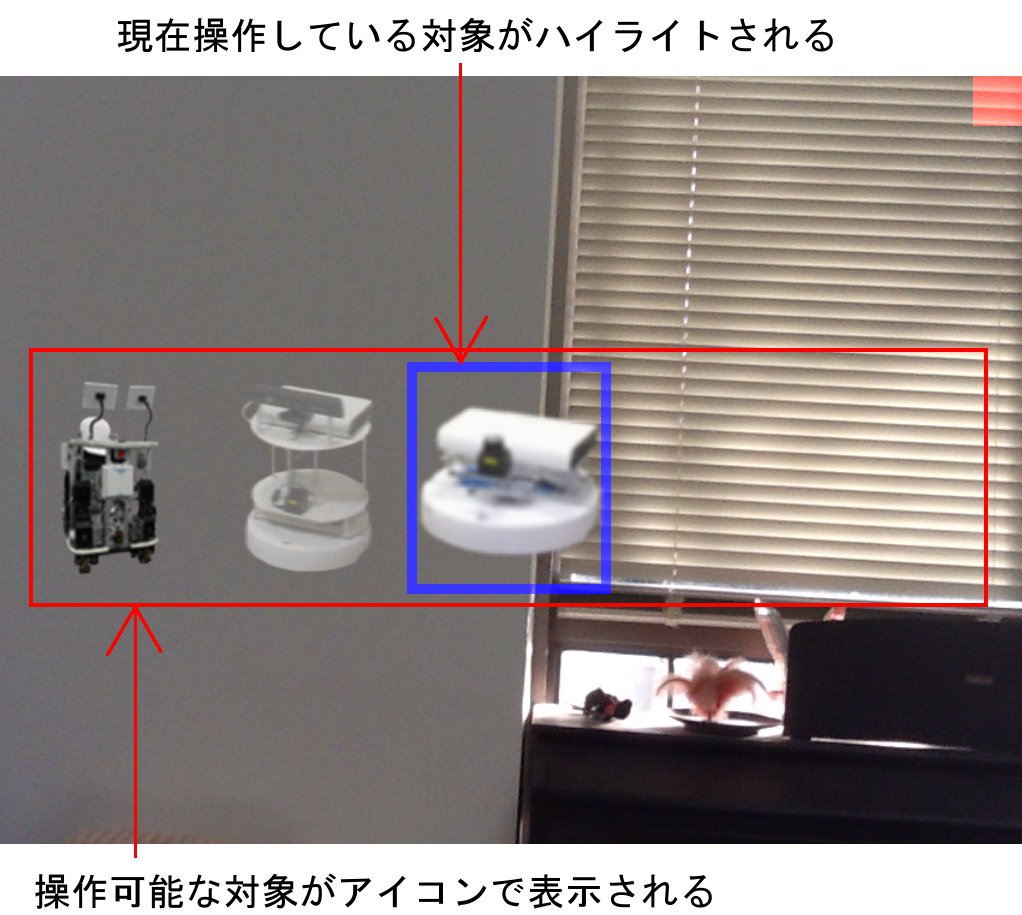

搭乗者への情報提示を透過型ヘッドマウントディスプレイで行うため、ATのコンソールタブレットには\ref{sec3-4}節で述べた情報とは別の情報を表示することが可能となる。そこで、ATのコンソールタブレット画面には搭乗者が現在ジェスチャによって操作している対象が何であるかを表示させる。コンソールタブレット画面に表示する画像を図に示す。

図5.6: ジェスチャ操作対象の提示

図のように、コンソールタブレット画面にはその時点でジェスチャによって操作可能な機械のアイコンが並んで表示される。基本的に、ジェスチャ操作可能な機械は、ATの移動に伴って変化することを想定している。図では、左から順にAT、SUV(RGB-Dカメラ搭載)、SUV(RGB-Dカメラ非搭載)がアイコンで表現されている。また、現在ジェスチャによって操作している機械を青色の線によってハイライトしている。なお、操作対象は搭乗者の手がXtionの前を左から右に横切ることで右隣りの機械に切り替わり、右から左に横切ることで左隣りの機械に切り替わる。

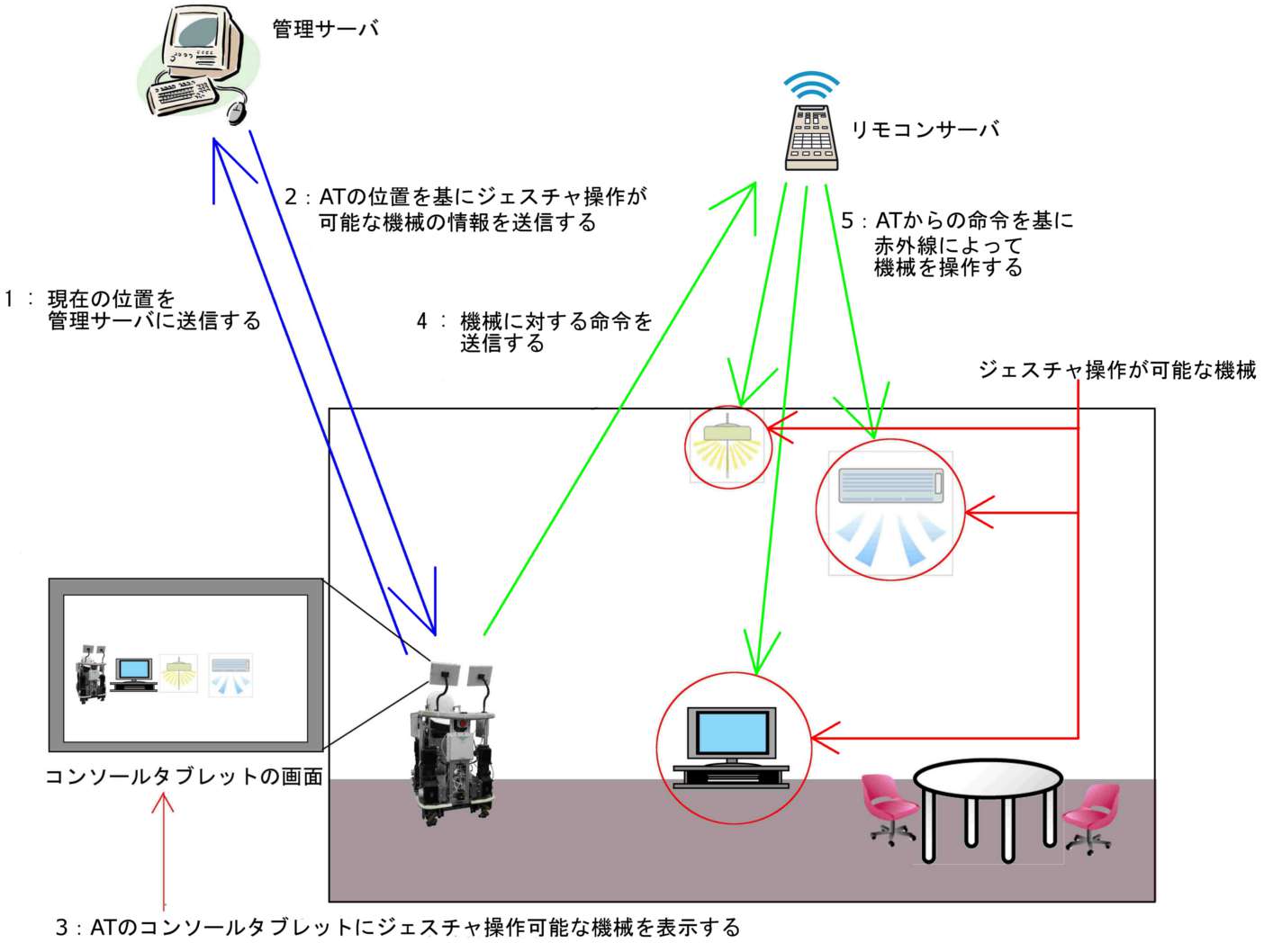

将来は、屋内の様々な機械が無線によって操作できるものになると考えられる。その上で、ATにはその時点での位置に連動してジェスチャ操作可能な機械が通知され、搭乗者がジェスチャ操作を行う機械を選択することが可能となる。図に将来実現すると考えられる仕組みの予想図を示す。

この図について説明する。管理サーバとは、屋内の地図情報やジェスチャ操作が可能な機械の位置情報などのデータを管理しているサーバであり、リモコンサーバとは、ATから機械に対する命令を受け取り、その命令を基に操作対象の機械に対して赤外線を送信するサーバである。

以下にジェスチャ操作の流れを示す。

-

ATが自身の位置を管理サーバに送信する。

-

管理サーバはATから送られてきた位置情報を基に、その付近でジェスチャ操作が可能な機械の情報をATに送信する。

-

管理サーバから送られてくる情報を基に、ATのコンソールタブレット画面にジェスチャ操作が可能な機械をアイコンで表示し、搭乗者に対して情報提示を行う。

-

搭乗者がジェスチャ操作の対象となる機械を選択し、ジェスチャ操作を開始する。その後、搭乗者のジェスチャによる命令がリモコンサーバに送信される。

-

リモコンサーバがATからの命令を基に操作対象の機械に対して赤外線を送信し、機械を操作する。

ATの移動に伴いながらこれらの手順を繰り返し行うことで、ATに搭乗しながら周囲の機械をジェスチャで操作する仕組みが実現されると考えられる。

図5.7: 将来実現されると考えられるジェスチャ操作環境の予想図

6 関連研究

6.1 身体動作インタフェースを利用した電動車椅子の操作

現在の電動車椅子は、主にジョイスティックを用いて操縦されている。しかし、ジョイスティックを用いた操縦方法は必ずしも直感的ではなく、ジョイスティックの操作ミスが車椅子走行時の事故に繋がることも考えられる。そのため、より直感的に操縦可能となる操縦インタフェースを開発することは意義があると考えられる。

そこで、横田らはジョイスティックを使用しない、電動車椅子の直感的な操縦インタフェースとして搭乗者の身体動作を利用した仕組みを実現した。横田らは、人間の行動・行為に付随する人間の固有の動作に着目し、この身体動作により生じる椅子と身体との接触面の圧力分布変化を電動車椅子の操縦に用いた。人間の行動・行為に付随する人間の固有の動作とは、乗り物に乗っている場合に起こる、移動方向に上半身が傾く現象などの人間が意識しなくても発生する身体部位の動作のことである。

横田らは搭乗者の身体動作に伴って生じる、搭乗者の背中と電動車椅子の背もたれの間の圧力変化を用いた身体動作インタフェースを実現し、それが電動車椅子の直感的な操縦を実現するインタフェースとなる可能性を示した。しかし、この手法を用いた場合、搭乗者が電動車椅子を操縦する意図とは関係なく上半身を傾けた場合に誤作動する可能性があるという問題がある。また、ATの操縦インタフェースとして考えた場合、全方位への平行移動を行う際に、搭乗者の背中と電動車椅子の背もたれの間の圧力変化を用いるだけでは平行移動の方向をうまく指定することができないと考えられる。一方、深度センサを用いたジェスチャ操縦ならば、進みたい方向を分かりやすい動作で指定することができると考えられる。

6.2 Designing Laser Gesture Interface for Robot Control

近年の技術の発展に伴い、家庭用ロボットが普及してきている。そのようなロボットを操作するインタフェースは人間にとってより分かりやすいものである必要がある。そこで、石井らはロボットの操作インタフェースとしてレーザポインタを使用する仕組みを提唱している。

石井らの研究では、まずレーザポインタによって操作の対象となる物体を選択し、その後行わせたい動作に対応したコマンドをレーザポインタで示すことでロボットの操作を行う。

しかし、ATの操縦インタフェースとしてレーザポインタの使用を考えた場合にいくつか問題点がある。石井らの仕組みではレーザポインタの軌跡や操作の対象となる物体を認識するために室内に多くの機器が取り付けられており、レーザポインタで操作可能となる範囲が限定されている。そのため、ATがレーザポインタによって操縦可能となる範囲から出てしまうとレーザポインタを用いた操縦はできなくなってしまう。また、操作デバイスとなるレーザポインタを常に携帯していなければならず、これも操作者の負担になると思われる。一方、ジェスチャ認識デバイスがATに組み込まれている本提案手法ならば、ATがどこに移動してもジェスチャ操縦を行うことができ、また、人間がデバイスを保持しない非接触型のユーザインタフェースであるため、操作者の負担は少なくなると考えられる。

6.3 ジェスチャ操作を活用する広視野電子作業空間の設計と実装

近年では、PCで行いたい作業が増加してきており、モニタの画面が次第に窮屈なものになってきている。木村らはコンピュータ・モニタの高解像度化と大型化だけでは、この問題を解決できないと捉え、さらに広くて使いやすい電子作業領域が求められると考えている。

そこで、木村らは複数のプロジェクタで映像を同時に投影する広視野ディスプレイによる広視野電子作業空間を提唱し、その操作インタフェースとしてジェスチャを用いている。この仕組みはMRキューブと呼ばれ、複数の応用が考えられている。

木村らの仕組みにより、広視野電子作業空間で映像の再生・編集や各種医用画像の閲覧・整理などの応用が実現されているが、ジェスチャ認識を行う際に、操作者が手袋型のデバイスを常に身につけている必要があり、操作者の負担になると考えられる。しかし、本研究で開発したATのジェスチャ操縦インタフェースは深度センサを利用するものであり、操作者が常にジェスチャ認識のためのデバイスを身につける必要がない。そのため、操作者はより自然な動作でジェスチャを行うことができると考えられる。

6.4 ジェスチャ認識に基づくインテリジェントルームの構築

我々の身の回りにある機械の多くはボタンやリモコンなどで操作されるものが多い。しかし、ボタンによる操作は操作する位置が限定されているために、操作者が移動する必要があり不便である。また、リモコンによる操作は操作者が移動することなく機械を操作可能となる一方で、操作者がリモコンの位置を把握していないために、リモコンを探し出すという手間が増える可能性がある。そこで、入江らはジェスチャを用いて室内の複数の家電製品を操作するインテリジェントルームを提唱している。

入江らの仕組みでは、室内に取り付けられている2台のカメラを用いてジェスチャ認識を行う。ジェスチャを行う人はまず手振り動作を行い、これからジェスチャによって機械を操作する意図をシステムに伝える。室内のカメラが人間の手振り動作を認識すると、カメラがその人間に注目し、ジェスチャ認識が開始される。その後、指差し動作によって操作する家電製品を選択し、あらかじめ決められているジェスチャ動作で家電製品を操作することが可能となる。

これまでの研究ではジェスチャ認識を行う空間がジェスチャ認識デバイスの正面などに限定されていたが、入江らの仕組みではジェスチャ認識可能な空間が室内の任意の場所までに拡張された。しかし、ATにジェスチャ認識デバイスを搭載した本研究の仕組みでは、ジェスチャ認識を行う環境ごと移動することが可能である。そのため、一つのジェスチャ認識デバイスで様々な機械を操作する仕組みが実現されると考えられる。

7 まとめと今後の課題

7.1 まとめ

筆者の所属する研究室では、人間の情報処理だけを支援するのではなく、その物理的な行動も同時に支援しようという搭乗型コンピューティングのコンセプトに基づいて、情報処理技術と通信機能が搭載された個人用知的移動体ATの研究開発を行っている。ATにはレーザレンジセンサと呼ばれる装置が搭載されており、ATの周囲の障害物までの距離情報を取得することができる。また、メカナムホイールと呼ばれる機構を駆動輪として用いることで、一般的な乗り物とは異なり、全方位への平行移動とその場回転を行うことが可能となる。

全方位平行移動ができるため、ATを操縦する際のインタフェースは、従来の乗り物を操縦する際のインタフェースとは異なる。また、電動車椅子などと比べて、より搭乗者の直感に合った操縦方法が求められる。そこで本研究では、新しい操縦インタフェースとして、Xtionと呼ばれる深度センサを用いたジェスチャによる操縦方法を実現した。Xtionは周囲の深度情報を取得することができ、ATはその情報を用いてジェスチャ認識を行う。

ATは全方位平行移動とその場回転の2種類の動作が可能であるため、ジェスチャをそれら2種類の動作に対応したものにする必要がある。そこで、全方位平行移動を行う際は手の形状をグーにし、その場回転を行う際は手の形状をパーにすることで動作を区別する。その形状のまま手を動かし、手の基準点の座標と認識範囲の中心点の座標の差分を計算することでATの操縦を行う。

また、搭乗者に対して、自身のジェスチャがどのように認識されているのか分かるように適切なフィードバックを行うための手法として、ジェスチャ認識結果(認識されている手の形状をそのまま図的に表示する)画面を用いる手法とジェスチャ認識結果に基づいたアニメーショングラフィクスを用いる手法の2種類を実現した。アニメーショングラフィクスによる情報提示手法ではジェスチャ認識結果だけではなく周囲の障害物に対する情報も提示することで搭乗者に注意を促す。

本研究で実現した2種類の情報提示手法について比較実験を行い、どちらがより適切な情報提示手法であるかの調査を行った。その結果、アニメーショングラフィクスを用いる手法の方が搭乗者にとって分かりやすい情報提示を行っていることが確認され、操縦のためのジェスチャを習得する際にも有効であることが示された。

また、操縦のためのジェスチャそのものも分かりやすいものであった、という結果が得られ、ATの操縦インタフェースとしてジェスチャを用いることは他の手法に比べてより直感的なものであると考えられる。

7.2 今後の課題

7.2.1 操縦のための新たなジェスチャの追加

比較実験を行う際に、被験者にはあらかじめ操縦のためのジェスチャを一通り教示していたが、伝えたジェスチャとは異なるジェスチャを行う被験者が複数名見受けられた。そのほとんどがATをその場回転させようとして手首を曲げる動作であった。

筆者が期待したジェスチャは手を左右に動かすことであったが、それらの被験者にとってはATをその場回転させるには手首を曲げるジェスチャの方がより直感的であったのだと考えられる。

このようなジェスチャを行う被験者が複数名見受けられたため、より直感的なインタフェースを実現するために手首を曲げることによってもその場回転ができるようにするべきだと考える。また、今後も同じようなことが起こり得ると考えられるため、直感的なジェスチャについて再考する必要があると考えられる。

7.2.2 情報提示手法の改良

第3章で述べたように、本研究では搭乗者への情報提示を行う手法としてジェスチャ認識結果画面を用いる手法とアニメーショングラフィクスを用いる手法を実現した。また、比較実験の結果、アニメーショングラフィクスを用いる手法の方が情報提示手法として有効であることが確認できた。

しかし、どちらの手法でも情報提示はATのコンソールタブレット画面で行われるため、まだATのジェスチャ操縦に慣れていない搭乗者はコンソールタブレット画面ばかりに注目すると考えられる。そのため、搭乗者の周囲に対する集中力が低下してしまう恐れがある。そこで、第5章でも述べたように、透過型のヘッドマウントディスプレイに映像を表示することで、搭乗者が周囲の風景に視線を向けていても適切に情報提示を行うことができる仕組みが実現されると考えられる。

また、透過型のヘッドマウントディスプレイに情報を表示することで、ATのコンソールタブレット画面には他の補助的な情報を表示することが可能になるという利点もある。透過型のヘッドマウントディスプレイならば、コンソールタブレット画面を見ながらヘッドマウントディスプレイに映し出された映像も見ることが可能となるため、より効率的に情報提示ができると考えられる。

7.2.3 ジェスチャによって周囲の機械を操作する機能の実装

第5章で述べたように、ATにジェスチャ認識の仕組みを組み込むことで、ATがどこにいてもジェスチャ認識を行うことが可能となる。そこで、ATが周囲の機械と通信することで、様々な機械をジェスチャによって操作可能とする環境が実現されると考えられる。

そのために、操作対象となる機械もしくはその機械を操作するためのリモコンなどとATの間で通信を行う仕組みを実現しなければならない。また、それぞれの機械を操作するためのジェスチャも決定する必要がある。さらに、ジェスチャによって機械を操作していることを搭乗者に対して分かりやすくフィードバックする必要もある。

これらの問題が解決されたならば、一つのジェスチャ認識デバイスを用いて、日常的な様々な機械をジェスチャによってより直感的に操作できる、新しい汎用的な仕組みが実現されると考えられる。

謝辞

本研究を遂行するにあたり、指導教員である長尾確教授をはじめとして、数多くの方々に御支援、御協力を頂きました。ここに感謝の意を表します。

本研究を進めるにあたり、指導教員である長尾確教授には、研究に対する心構えなどの基礎的なことから、ゼミを通しての貴重な御意見、論文執筆に関する御指導など、大変御世話になりました。心より御礼申し上げます。

松原茂樹准教授並びに、大平茂輝助教には、研究室の全体ゼミにおいて貴重な御意見、御指摘を頂き、大変御世話になりました。心より御礼申し上げます。

石戸谷顕太朗さんには、ゼミ等で貴重な御意見を頂いたことに加え、基礎的な知識を身に付けるにあたり数々の御指導をして頂きました。ありがとうございました。

ATプロジェクトメンバーである渡邉賢さん、尾崎宏樹さんには、本研究を進める上で必要不可欠なATに関する技術的な御指導や、プログラミングに関する様々なアドバイスを頂くなど、大変お世話になりました。ありがとうございました。

高橋勲さん、棚瀬達央さん、川西康介さんには、ゼミ等で貴重な御意見を頂いたことに加え、研究室での活動の中でも大変御世話になりました。ありがとうございました。

長尾研究室秘書である鈴木美苗さんには、研究生活や学生生活の様々な面で御世話になりました。ありがとうございました。

また、石井健一郎教授、鳥海不二夫助教をはじめ、石井研究室メンバーのみなさまには、実験場所として研究室前の廊下の使用を許していただき、ありがとうございました。 IB電子情報館南棟3階の大西研究室、渡辺研究室のみなさまには、実験場所として共有スペースの使用を許していただき、ありがとうございました。心より御礼申し上げます。

最後に、陰ながら見守って頂き、日々の生活を支えて頂いた家族にも最大限の感謝の気持ちをここに表します。ありがとうございました。